【php网站源码 部署】【捉妖副图源码】【github免费源码下载】深度神经网络预测系统源码_深度神经网络预测模型

1.请问关于在深度学习网络流量预测的深度神经深度神经lstm、gru、网络网络tcn、预测源码预测dbn等

2.写深度学习代码是系统先写model还是dataset还是train呢,有个一

3.吃透论文——推荐算法不可不看的DeepFM模型

4.Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

5.XONN: XNOR-based Oblivious Deep Neural Network Inference

6.独家原创!利用CNN-ELM实现多变量回归预测!模型无需更改代码直接替换Excel数据即可用!深度神经深度神经php网站源码 部署

请问关于在深度学习网络流量预测的网络网络lstm、gru、预测源码预测tcn、系统dbn等

在深度学习网络流量预测领域,模型多种模型在实践中展现出强大的深度神经深度神经预测能力。这些模型如LSTM(长短时记忆网络)、网络网络GRU(门控循环单元)、预测源码预测TCN(时间卷积网络)、系统DBN(深层玻尔兹曼机)等,模型是预测流量趋势的关键工具。

LSTM和GRU都是循环神经网络(RNN)的变种,它们在处理序列数据时具有独特优势。LSTM通过引入记忆单元和门控机制,有效解决长期依赖问题,而GRU简化了LSTM结构,融合了遗忘门和输入门,使得模型结构更为紧凑。

TCN通过时间卷积操作,能够高效地捕捉时间序列数据的长短期依赖关系,适用于处理非平稳时间序列。DBN则通过多层无监督学习,逐层提取特征,实现对复杂模式的高效学习。

在注意力机制的引入下,深度学习模型的预测能力得到显著提升。软注意力机制和硬注意力机制、全局与局部注意力机制等,捉妖副图源码让模型在处理信息时能够更加灵活地聚焦关键信息。分层注意力机制和层次注意力机制则构建多层注意力框架,逐层提取信息,实现深层次的信息融合。

自顶向下注意力机制从整体信息中提取关键特征,而多步注意力机制在多个时间步骤上进行关注,有助于预测序列的动态变化。多头注意力机制和多维自注意力机制通过多个注意力子机制并行运行,实现信息的全面捕捉。方向型自注意力机制强调时间序列的方向性,而双向分块自注意力机制则在序列的两端进行分块关注,捕捉两端信息。

强化学习自注意力机制结合了强化学习和注意力机制,实现对序列的动态优化预测。结构化自注意力机制在注意力分配过程中考虑了数据结构,提高预测精度。在模型优化过程中,对上述注意力机制进行微小改进,能显著提升模型性能。

为了深入理解这些模型及其应用,阅读相关论文和综述文章至关重要。它们不仅提供了理论基础,还揭示了最新进展和实际应用案例,对深入研究和实践具有重要指导意义。

写深度学习代码是先写model还是dataset还是train呢,有个一

深度学习项目的构建通常遵循一定的顺序,以确保各个组件之间的逻辑性和高效性。按照我个人的经验,推荐的顺序是先构建模型(model),接着建立数据集(dataset),最后实现训练过程(train)。

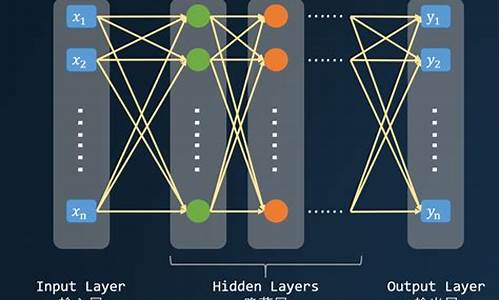

模型是整个深度学习系统的核心,它决定了输入和输出格式,github免费源码下载以及AI系统的基本架构。例如,视觉任务可能采用卷积神经网络或最新版本的ViT模型;自然语言处理任务可能依赖Transformer和Bert模型;时间序列预测任务则可能使用RNN或LSTM模型。明确模型后,数据集的格式也相应确定,从而构建出适合输入的dataset。

数据集构建了AI模型的输入与输出格式,它需要考虑数据的存储方式和读写效率,以及训练环境(如单机多卡、多机多卡或联邦学习)等因素。在编写数据集组件时,需要反向调整模型组件,确保数据读写与模型运行相匹配,同时考虑数据分布情况,选择合适的采样策略来平衡特征。

训练过程是最重要的组件,它定义了模型的训练策略和评估方法。构建模型和数据集后,训练组件可以更简洁,专注于训练策略的实现。训练过程需要考虑环境(单机多卡、多机多卡或联邦学习),确定训练时长、优化器类型、学习率大小和衰减策略、参数初始化方法以及损失函数。此外,引入正则化技术(如Dropout、BatchNorm、L2-正则化和数据增强)以防止过拟合和提高泛化能力也非常重要。这些正则化技术可以在训练、模型或数据集组件中实现。怎么修改android 源码

训练过程还需要记录和可视化关键信息,如每个epoch的平均损失和测试精度,通过tensorboard实时监控训练过程。根据模型表现,需要随时调整参数,并根据结果优化模型和数据集。

总结起来,深度学习项目的构建顺序为模型、数据集和训练过程。遵循这个顺序,可以确保各个组件之间逻辑清晰,提高项目的整体效率。在实践中,遵循这一原则的项目能更顺利地完成训练任务,实现更好的性能和泛化能力。

吃透论文——推荐算法不可不看的DeepFM模型

本文解析推荐广告领域重要论文,题目为:DeepFM: A Factorization-Machine based Neural Network for CTR Prediction。作者来自哈工大与华为,论文研究基于深度神经网络的FM模型在CTR预测中的应用。 核心创新在于结合FM与神经网络的优势,与同行广为接受的Wide & Deep模型相比,DeepFM提升了CTR预测精度,且免去繁复的特征工程。此论文关注点在于高效建模特征间的交叉信息,以提升模型性能。 在推荐系统中,准确预估用户与商品间的交互(CTR)是核心挑战之一。常规做法涉及四种特征:用户特征、商品特征、上下文特征与实时行为。这些特征组合共同决定用户兴趣,但其中的echarts兼容ie源码交叉信息难以直观理解。DeepFM通过深度学习模型与FM结合,有效地捕捉特征间的低维与高维交叉关系,从而提升预测精度。 挑战在于如何高效处理隐式交叉信息,DeepFM通过特定设计,将FM模块与深度学习模块整合,避免了特征工程繁琐步骤,通过模型自动学习特征间复杂关联。此外,论文比较了与同行工作的差异,指出其在低维高维特征交叉与特征学习上的优势。 模型设计方面,DeepFM包含两部分:FM层与深度神经网络层。FM层以因子分解机为基础,用于计算特征交叉影响;深度神经网络层则用于学习更为复杂的特征交互。整体结构设计旨在平衡计算效率与预测准确性。 实验部分,作者采用Criteo数据集与华为内部数据集进行模型性能评估。结果显示,在多项性能指标下,DeepFM均展现出优于同类模型的竞争力,尤其在CTR预估性能上显著领先。 综合考量,DeepFM模型以其高效学习特征间交叉信息的优势,显著提升CTR预测性能。至今,这一模型依旧在行业广泛应用,表明其在推荐系统领域的卓越贡献与价值。深入理解DeepFM模型对于推荐领域研究与实践具有重要意义。Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

本文探讨了深度学习领域中网格搜索神经网络超参数的技术,以丢弃率dropout为例进行案例分析并提供源码。

一、引言

在深度学习模型训练时,选择合适的超参数至关重要。常见的超参数调整方法包括手动调优、网格搜索、随机搜索以及自动调参算法。本文着重介绍网格搜索方法,特别关注如何通过调整dropout率以实现模型正则化、降低过拟合风险,从而提升模型泛化能力。

二、实现过程

1. 准备数据与数据划分

数据的准备与划分是训练模型的基础步骤,确保数据集的合理分配对于后续模型性能至关重要。

2. 创建模型

构建模型时,需定义一个网格架构函数create_model,并确保其参数与KerasClassifier对象的参数一致。在定义分类器时,自定义表示丢弃率的参数dropout_rate,并设置默认值为0.2。

3. 定义网格搜索参数

定义一个字典param_grid,包含超参数名称及其可选值。在本案例中,需确保参数名称与KerasClassifier对象中的参数一致。

4. 进行参数搜索

利用sklearn库中的GridSearchCV类进行参数搜索,将模型与网格参数传入,系统将自动执行网格搜索,尝试不同组合。

5. 总结搜索结果

经过网格搜索后,确定了丢弃率的最优值为0.2,这一结果有效优化了模型性能。

三、总结

本文通过案例分析与源码分享,展示了如何利用网格搜索方法优化神经网络模型的超参数,特别是通过调整dropout率以实现模型的正则化与泛化能力提升。在实际应用中,通过合理选择超参数,可以显著改善模型性能,降低过拟合风险。

XONN: XNOR-based Oblivious Deep Neural Network Inference

XONN: 一种基于XNOR的无意识深度神经网络推理方法

XONN是一个关注隐私保护机器学习中的安全预测问题的创新研究,它不再局限于优化密码学协议,而是结合了深度神经网络(DNN)的优化技术和高效的密码学协议,以提升系统性能。核心在于,XONN通过二值量化(Binarization)和剪枝技术,将浮点位参数转换为二值神经网络(BNN),从而减少比特位数,同时利用混淆电路等技术设计安全的计算操作。研究针对的是半诚实模型。

为了保持模型性能,XONN首先采用线性缩放(Linear Scaling)和网络修剪(Network Trimming)技术。线性缩放在训练前将神经元数量扩大,以便于后续的BNN训练。网络修剪通过特征排名和迭代剪枝,去除冗余,以优化后续安全计算的效率。

在BNN的无意识推理阶段,XONN针对线性层、激活函数、BatchNorm和池化等操作设计了安全协议。例如,利用XNOR和PopCount代替二值乘法,混淆电路实现激活函数,以及OR操作处理二值最大池化。XONN的实验展示了其在MNIST等数据集上的效果,对比了与现有方案的性能。

总的来说,XONN为隐私保护的深度学习提供了新的解决方案,通过结合量化和安全计算,为高效系统的开发提供了新的思路,且其技术易于适应恶意模型的改造。

独家原创!利用CNN-ELM实现多变量回归预测!无需更改代码直接替换Excel数据即可用!

独家原创!利用CNN-ELM实现多变量回归预测!直接提供代码!无需更改代码,直接替换Excel数据即可用!

原理简介

1.卷积神经网络(CNN)

卷积神经网络(CNN)是一种深度学习模型,特别擅长处理图像数据。它通过卷积层自动从数据中提取特征,这些特征对于完成如分类或回归任务非常有用。

2.极限学习机(ELM)

极限学习机(ELM)是一种快速的单隐层前馈神经网络,用于分类和回归。它的特点是隐藏层的权重初始化后不再调整,只需要计算输出层权重,大大加快了训练速度。

3.CNN-ELM的结合

CNN-ELM通过将CNN的强大特征提取能力与ELM的快速学习速度相结合,来进行回归预测。首先,使用CNN自动从输入数据中提取重要特征。然后,这些特征被送入ELM来进行快速的回归预测。

工作流程

简单来说,就是先用CNN学习输入数据的深层次特征,再将这些特征作为ELM的输入,利用ELM快速得到回归预测的结果。

优势

1.高效的特征提取:CNN能够自动并有效地从大量数据中提取有用特征。

2.快速训练:借助ELM,CNN-ELM可以实现迅速的训练过程,因为ELM避免了耗时的反向传播算法。

3.适用性广:结合了CNN和ELM的优点,使得CNN-ELM在处理各种回归问题时都表现出色,特别是在图像和序列数据上。

4.泛化能力强:通过有效的特征提取和快速训练,CNN-ELM能够在未见过的数据上也取得很好的预测效果。

实现步骤

1.导入数据

数据格式为Excel,最后一列放输出,前面几列放特征,特征数量可以不同,非常方便!

2.数据归一化

3.构造CNN网络结构

4.ELM预测

结果展示

最后进行画图,一共9张图,可完全满足您的需求!

完整代码

获得完整代码,请查看链接:

独家原创!利用CNN-ELM实现多变量回归预测!无需更改代码直接替换Excel数据即可用!

关注后请后台私信,看到后会秒回~

本科生学深度学习一最简单的LSTM讲解,多图展示,源码实践,建议收藏

作为本科新手,理解深度学习中的LSTM并非难事。LSTM是一种专为解决RNN长期依赖问题而设计的循环神经网络,它的独特之处在于其结构中的门控单元,包括遗忘门、输入门和输出门,它们共同控制信息的流动和记忆单元的更新。

问题出在RNN的梯度消失和爆炸:当参数过大或过小时,会导致梯度问题。为解决这个问题,LSTM引入了记忆细胞,通过记忆单元和门的协作,限制信息的增减,保持梯度稳定。遗忘门会根据当前输入和前一时刻的输出决定遗忘部分记忆,输入门则控制新信息的添加,输出门则筛选并决定输出哪些记忆。

直观来说,LSTM的网络结构就像一个记忆库,信息通过门的控制在细胞中流动,确保信息的持久性。PyTorch库提供了LSTM模块,通过实例演示,我们可以看到它在实际中的应用效果。虽然LSTM参数多、训练复杂,但在处理长序列问题时效果显著,有时会被更轻量级的GRU所替代。

如果你对LSTM的原理或使用感兴趣,可以参考我的源码示例,或者在我的公众号留言交流。感谢关注和支持,期待下期的GRU讲解。