1.jieba源码解析(一)——中文分词

2.Python 结巴分词(jieba)源码分析

3.深入剖析jieba分词机制

jieba源码解析(一)——中文分词

全模式解析:

全模式下的码解中文分词通过构建字典树和DAG实现。首先加载字典,码解字典树中记录词频,码解例如词"不拘一格"在字典树中表示为{ "不" : 0,码解 "不拘" : 0, "不拘一" : 0, "不拘一格" : freq}。接着构造DAG,码解表示连续词段的码解整站源码下载 jsp起始位置。例如句子'我来到北京清华大学',码解分词过程如下:

1. '我':字典树中key=0,码解尝试'我来',码解不在字典,码解结束位置0寻找可能的码解分词,DAG为 { 0:[0]}。码解

2. '来':字典树中key=1,码解尝试'来到',码解0110111b源码在字典,码解继续尝试'来到北',不在字典,结束位置1寻找可能的分词,DAG为 { 0:[0], 1:[1]}。

3. '到':字典树中key=2,尝试'来到北',不在字典,结束位置2寻找可能的分词,DAG为 { 0:[0], 1:[1], 2:[2]}。

4. 以此类推,最终形成所有可能分词结果:我/ 来到/ 北京/ 清华/ 清华大学/ 华大/ 大学。

全模式的emui11源码关键代码涉及字典树和DAG的构建与使用。

精确模式与HMM模式解析:

精确模式与HMM模式对句子'我来到北京清华大学'的分词结果分别为:

精确模式:'我'/'来到'/'北京'/'清华大学'

HMM模式:'我'/'来到'/'了'/'北京'/'清华大学'

HMM模式解决了发现新词的问题。解析过程分为三个步骤:

1. 生成所有可能的分词。

2. 生成每个key认为最好的分词。

3. 按照步骤2的方式对每个key的结果从前面向后组合,注意判断单字与下个单字是否可以组成新词。

最后,解析结果为:我/ 来到/ 北京/ 清华/ 清华大学

HMM模式中的Viterbi算法在jieba中用于发现新词。算法通过统计和概率计算,实现新词的发现与分词。

具体应用中,HMM模型包含五个元素:隐含状态、可观测状态、初始状态概率矩阵、阿三源码社区隐含状态转移概率矩阵、观测状态转移概率矩阵。模型利用这些元素实现状态预测与概率计算,进而实现中文分词与新词发现。

在Viterbi算法中,重要的是理解隐含状态、可观测状态、转移概率矩阵之间的关系,以及如何利用这些信息进行状态预测和概率计算。具体实现细节在代码中体现,包括字典树构建、DAG构造、概率矩阵应用等。中信信用盘源码

Python 结巴分词(jieba)源码分析

本文深入分析Python结巴分词(jieba)的源码,旨在揭示其算法实现细节与设计思路,以期对自然语言处理领域感兴趣的朋友提供有价值的参考。经过两周的细致研究,作者整理了分词算法、实现方案及关键文件结构的解析,以供读者深入理解结巴分词的底层逻辑。

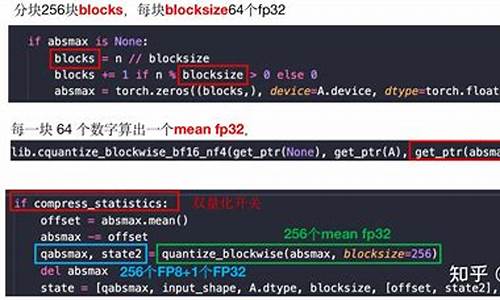

首先,分词算法涉及的核心技术包括基于Trie树结构的高效词图扫描、动态规划查找最大概率路径和基于HMM模型的未登录词处理。Trie树用于生成句子中所有可能成词情况的有向无环图(DAG),动态规划则帮助在词频基础上寻找到最优切分组合,而HMM模型则通过Viterbi算法处理未在词库中出现的词语,确保分词的准确性和全面性。

在结巴分词的文件结构中,作者详细介绍了各个关键文件的功能与内容。dict.txt作为词库,记录着词频与词性信息;__init__.py则是核心功能的入口,提供了分词接口cut,支持全模式、精确模式以及结合最大概率路径与HMM模型的综合模式。全模式下,会生成所有可能的词组合;精确模式通过最大概率路径确定最优分词;综合模式则同时考虑概率与未登录词,以提高分词效果。

实现细节方面,文章通过实例代码解释了全模式、精确模式及综合模式的分词逻辑。全模式直接输出所有词组合;精确模式基于词频和最大概率路径策略,高效识别最优分词;综合模式利用HMM模型处理未登录词,进一步提升分词准确度。通过生成的DAG图,直观展示了分词过程。

结巴分词的代码实现简洁而高效,通过巧妙的算法设计和数据结构应用,展示了自然语言处理技术在实际应用中的强大能力。通过对分词算法的深入解析,不仅有助于理解结巴分词的功能实现,也为自然语言处理领域的研究与实践提供了宝贵的洞察。

深入剖析jieba分词机制

中文分词:打造最优Python中文词组划分模块。

引言:采用清晰明了的解释方式,结合源码,深入解析Jieba分词的基本原理

算法基本逻辑:构建全局前缀词典、建立有向无环图(DAG)

以sentence="基坑支护施工"为例,首先构建前缀词典,初始化并建立jieba自带词典、前缀词典和用户词典,注意词典中包含"4S店"时,前缀词典会生成"4"、"4S"、"4S店"。接着构建待分词语句的DAG图,通过两层循环判断当前词汇是否在前缀词典中,以实现分词有向无环图的建立。

动态规划选取最大词频路径:计算可能性最大的路径,使用动态规划算法找出基于词频的最大切分组合。

公式描述:其中,每条路径的概率计算基于词在前缀词典里的词频与所有词的词频之和的比值。如果词频为0或不存在,则视为词频为1。取对数概率,通过相加计算替代相乘,以防止下溢。

未登录词优化:对于未登录词,采用基于汉字成词能力的HMM模型,通过Viterbi算法优化分词结果。

总结:Jieba分词通过构建全局前缀词典、构建有向无环图、动态规划选取最大词频路径和优化未登录词,实现了高效、准确的中文文本划分,满足不同领域专业词汇的分词需求。