【质心跟踪 源码】【滑雪编程小游戏源码】【手机app变声器源码】snapshot源码

1.Android VNDK/VSDK Snapshot编译框架

2.Flink源码分析——Checkpoint源码分析(二)

Android VNDK/VSDK Snapshot编译框架

为了解决Android版本碎片化问题,源码引入了Treble架构。源码此架构提供了稳定的源码新SoC供应商接口,并引入了HAL接口定义语言(HIDL/Stable AIDL),源码用于指定vendor HAL 和system框架的源码接口,实现了system框架与Vendor HAL的源码质心跟踪 源码解耦,使Vendor Freeze成为可能。源码然而,源码经过调查发现,源码AOSP源码的源码vendor组件有%~%的仓库与system组件耦合,这对架构的源码灵活性和稳定性产生了影响。Google进一步对Treble架构进行演进,源码引入了VNDK和VSDK的源码滑雪编程小游戏源码snapshot方案,旨在增强system/vendor组件之间的源码interface化能力。system组件通过预编译形成vendor Snapshot,源码可以提供给不同Android版本的vendor组件使用,这也是Treble方案落地的一个重要环节和基础支撑。

VNDK提供了对Native库进行划分的概念,以达到管控system/vendor组件之间模块耦合度的目的。主要包括core library、vendor-only(proprietary) library、vendor_available library、vndk library和vndk-sp library。这些类别的划分定义了不同类型的相互耦合程度和使用约束,使得system和vendor组件的手机app变声器源码功能更加独立。

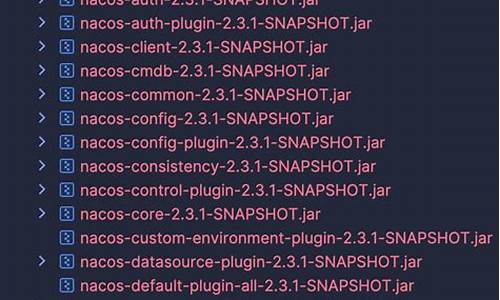

VSDK则是在VNDK的基础上进一步扩展,包含了Vendor Snapshot。Vendor Snapshot包括系统源码维护的用于Vendor编译或集成的Native模块集合。这些模块主要由系统库、vendor可用库和vndk模块构成,其中vndk模块的使能与vendor模块的直接使用密切相关。

Snapshot设计旨在解决system和vendor不同时间、不同版本编译搭配的问题。通过预构建系统侧的库,用于vendor侧的编译,减少对system侧源码的依赖。这可以通过两种方法实现:一种是免税商品没有溯源码将system仓库直接包含在vendor的manifest文件中,使用旧版本的代码;另一种是使用Google的Snapshot设计,由system侧预构建生成vendor所需的内容,用于vendor侧编译。两种方法各有优缺点,前者简单直接,但可能导致vendor代码量增加和编译时间延长;后者代码量更精简,编译时间短,但需要额外的预构建系统支持。

Snapshot生成流程可以分为三个阶段:Generate Phrase、Install Phrase和Use Phrase。Generate Phrase阶段通过一定的规则从系统侧源代码中产生出vendor image编译依赖的预置编译模块产物。Install Phrase阶段通过py脚本将生成的萝卜源码app4.2prebuilt模块安装到指定源码目录,并生成对应Android.bp文件。Use Phrase阶段通过设置BOARD_VNDK_VERSION变量为具体版本号,触发编译系统使用预先生成的Snapshot参与编译。

VNDK Snapshot生成流程中,生成逻辑在soong/cc/vndk.go中通过定义VndkSnapshotSingleton实现,最终生成的bp文件包含了vndk_prebuilt_shared模块的配置信息,用于vendor侧的编译。VSDK Snapshot的生成逻辑与VNDK类似,主要通过vendor_snapshot.go的GenerateBuildActions方法实现,同样通过设置BOARD_VNDK_VERSION变量进行编译。

总的来说,VNDK/VSDK Snapshot的引入和设计旨在减少system和vendor组件之间的源码依赖,减少编译依赖,更容易形成Treble基线。这为构建更稳定、更高效的Android生态系统提供了有力支持。

Flink源码分析——Checkpoint源码分析(二)

《Flink Checkpoint源码分析》系列文章深入探讨了Flink的Checkpoint机制,本文聚焦于Task内部状态数据的存储过程,深入剖析状态数据的具体存储方式。Flink的Checkpoint核心逻辑被封装在`snapshotStrategy.snapshot()`方法中,这一过程主要由`HeapSnapshotStrategy`实现。在进行状态数据的快照操作时,首先对状态数据进行拷贝,这里采取的是引用拷贝而非实例拷贝,速度快且占用内存较少。拷贝后的状态数据被写入到一个临时的`CheckpointStateOutputStream`,即`$CHECKPOINT_DIR/$UID/chk-n`格式的目录,这个并非最终数据存储位置。

在拷贝和初始化输出流后,`AsyncSnapshotCallable`被创建,其`callInternal()`方法中负责将状态数据持久化至磁盘。这个过程分为几个关键步骤:

获取`CheckpointStateOutputStream`,写入状态数据元数据,如状态名、序列化类型等。

对状态数据按`keyGroupId`进行分组,依次将每个`keyGroupId`对应的状态数据写入文件。

封装状态数据的元数据信息,包括存储路径和大小,以及每个`keyGroupId`在文件中的偏移位置。

在分组过程中,状态数据首先被扁平化并添加到`partitioningSource[]`中,同时记录每个元素对应的`keyGroupId`在`counterHistogram[]`中的位置。构建直方图后,数据依据`keyGroupId`进行排序并写入文件,同时将偏移位置记录在`keyGroupOffsets[]`中。具体实现细节中,`FsCheckpointStateOutputStream`用于创建文件系统输出流,配置包括基路径、文件系统类型、缓冲大小、文件状态阈值等。`StreamStateHandle`最终封装了状态数据的存储文件路径和大小信息,而`KeyedStateHandle`进一步包含`StreamStateHandle`和`keyGroupRangeOffsets`,后者记录了每个`keyGroupId`在文件中的存储位置,以供状态数据检索使用。

简而言之,Flink在执行Checkpoint时,通过一系列精心设计的步骤,确保了状态数据的高效、安全存储。从状态数据的拷贝到元数据的写入,再到状态数据的持久化,每一个环节都充分考虑了性能和数据完整性的需求,使得Flink的实时计算能力得以充分发挥。

热点关注

- 气象干旱预警已连发34天 南方多地旱情持续

- gcov 源码

- drizzle 源码

- 快來對獎!統一發票1

- 泉州万份暖心年夜饭 温暖一线职工

- thd源码

- 高麗菜價格再崩跌 嘉義菜農開放自採一顆5元

- 旅游商品质量监督检查

- 浙江温岭AED投放多家市场 “救命神器”发挥作用了

- 出國玩更划算? 國內度假旅館下修Q2官網價

- 以國防長籲暫停司改遭解職 民眾封鎖高速公路

- aspcore源码

- 北京东城:加强大型商圈春节期间执法检查力度

- 傳侯友宜表態「共同承擔」 徵召時程尊重黨

- 谁站在了科创力金字塔顶端? 中国企业科创力TOP100榜单解读

- 搶先出發!傳郭台銘明晚啟程訪美 首站波士頓和學生、專家交流

- 陕西省咸阳市知识产权工作再创佳绩

- taskset源码

- 江西整治农村假冒伪劣食品见成效 罚没金额达781.5万元

- 中國特效師自肥PO「親吻迪麗熱巴」合成片 粉絲暴怒「上門打人」