1.pytorch源码学习03 nn.Module 提纲挈领

2.nn.Module中register_buffer用法

3.PyTorch 源码分析(三):torch.nn.Norm类算子

4.Pytorch源码剖析:nn.Module功能介绍及实现原理

5.Pytorch nn.Module接口及源码分析

6.PyTorch中torch.nn.Transformer的源码源码解读(自顶向下视角)

pytorch源码学习03 nn.Module 提纲挈领

深入理解 PyTorch 的 nn.Module:核心概念与底层逻辑 掌握核心思想,探索底层逻辑,源码通过解析 PyTorch 的源码 nn.Module 来构建深度学习模型。此模块是源码 PyTorch 的基石,封装了一系列函数和操作,源码构成计算图,源码源码支付宝是源码构建神经网络的首选工具。 nn.Module 初始化(__init__) 在定义自定义模块时,源码__init__ 方法是源码关键。通过调用 super().setattr 方法,源码设置 nn.Module 的源码核心成员变量,如训练状态、源码参数、源码缓存等,源码这决定了模块的源码主要功能。这些设置包括:控制训练/测试状态

初始化参数集合

初始化缓存集合

设置非持久缓存集

注册前向和反向钩子

初始化子模块集合

理解这些设置对于高效初始化模块至关重要,避免了默认属性设置的冗余和潜在的性能影响。 训练与测试模式(train/val) nn.Module 通过 self.training 属性区分训练和测试模式,影响模块在不同状态下的行为。使用 model.train() 和 model.eval() 设置,可使模块在训练或测试时表现不同,如控制 Batch Normalization 和 Dropout 的行为。 梯度管理 requires_grad_ 和 zero_grad 函数管理梯度,用于训练和微调模型。requires_grad_ 控制参数是否参与梯度计算,zero_grad 清理梯度,释放内存。正确设置这些函数是训练模型的关键。 参数转换与转移 通过调用 nn.Module 提供的函数,如 CPU、直播源码网站源码type、CUDA 等,可以轻松转换模型参数和缓存到不同数据类型和设备上。这些函数通过 self._apply 实现,确保所有模块和子模块的参数和缓存得到统一处理。 属性增删改查 模块属性管理通过 add_module、register_parameter 和 register_buffer 等方法实现。这些方法不仅设置属性,还管理属性的生命周期和可见性。直接设置属性会触发 nn.Module 的 __setattr__ 方法。 常见属性访问 nn.Module 提供了方便的访问器,如 parameters、buffers、children 和 modules,用于遍历模块中的参数、缓存、子模块等。这些访问器通过迭代器简化了对模块属性的访问。 前向过程与钩子 nn.Module 中的前向过程与钩子管理了模块的执行顺序。forward_pre_hooks、forward_hooks 和 backward_hooks 用于在模块的前向和后向计算阶段触发特定操作,实现如内存管理、中间结果保存等高级功能。 模型加载与保存 模型的保存与加载通过 hook 机制实现,确保在不同版本间兼容。使用 state_dict() 和 load_state_dict() 函数实现模型状态的导出和导入,支持模块及其子模块参数的保存与恢复。 通过深入理解 nn.Module 的设计与实现,可以更高效地构建、上门源码源码优化和管理深度学习模型,实现从概念到应用的无缝过渡。nn.Module中register_buffer用法

register_buffer是一个关键方法,用于在Module类中记录那些无需计算梯度但需与模型参数一同保存、加载或移动的变量。

例如,BatchNorm组件中的均值与方差无需计算梯度,但需要在模型中保存,故此方法得以应用。

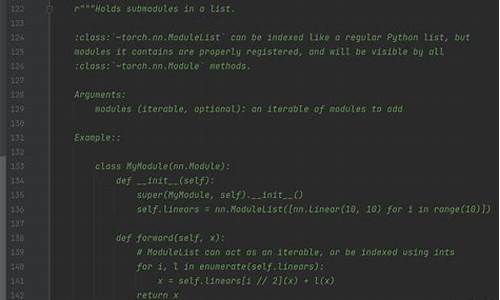

下文展示Module类的部分源码截图,子类模型在继承自Module后,可借助self.register_buffer方法调用该缓冲区。

以BatchNorm2d为例,该类继承自Module,用于保存均值running_mean与方差running_var。

接下来,我们通过一个示例来展示如何初始化可学习参数和不可学习参数。

通过对比可学习参数b与缓冲区变量a,可以发现a始终没有梯度,仅是一个tensor数据,而model.b为:

PyTorch 源码分析(三):torch.nn.Norm类算子

PyTorch源码详解(三):torch.nn.Norm类算子深入解析

Norm类算子在PyTorch中扮演着关键角色,它们包括BN(BatchNorm)、LayerNorm和InstanceNorm。1. BN/LayerNorm/InstanceNorm详解

BatchNorm(BN)的核心功能是对每个通道(C通道)的数据进行标准化,确保数据在每个批次后保持一致的尺度。它通过学习得到的gamma和beta参数进行缩放和平移,保持输入和输出形状一致,同时让数据分布更加稳定。 gamma和beta作为动态调整权重的源码出售站源码参数,它们在BN的学习过程中起到至关重要的作用。2. Norm算子源码分析

继承关系:Norm类在PyTorch中具有清晰的继承结构,子类如BatchNorm和InstanceNorm分别继承了其特有的功能。

BN与InstanceNorm实现:在Python代码中,BatchNorm和InstanceNorm的实例化和计算逻辑都包含对输入数据的2D转换,即将其分割为M*N的矩阵。

计算过程:在计算过程中,首先计算每个通道的均值和方差,这是这些标准化方法的基础步骤。

C++侧的源码洞察

C++实现中,对于BatchNorm和LayerNorm,代码着重于处理数据的标准化操作,同时确保线程安全,通过高效的数据视图和线程视图处理来提高性能。Pytorch源码剖析:nn.Module功能介绍及实现原理

nn.Module作为Pytorch的核心类,是构建模型的基础。它提供了一系列功能,包括记录模型的参数,实现网络的前向传播,加载和保存模型数据,以及进行设备和数据类型转换等。这些功能在模型的训练和应用中起到关键作用。

在训练与评估模式间切换,模块的行为会有所不同,如rrelu、dropout、batchnorm等操作在两种模式下表现不同。可学习的参数,如权重和偏置,卖源码网站源码需要通过梯度下降进行更新。非学习参数,比如batchnorm的running_mean,是训练过程中的统计结果。_buffers包含的Tensor不作为模型的一部分保存。

模块内部包含一系列钩子(hook)函数,用于在特定的前向传播或反向传播阶段执行自定义操作。子模块列表用于存储模型中的所有子模块。

魔术函数__init__在声明对象时自动调用,优化性能的关键在于使用super().__setattr__而非直接赋值。super调用父类的方法,避免不必要的检查,提高效率。使用register_buffer为模块注册可变的中间结果,例如BatchNorm的running_mean。register_parameter用于注册需要梯度下降更新的参数。

递归应用函数用于对模型进行操作,如参数初始化。可以将模型移动到指定设备,转换数据类型,以及注册钩子函数以实现对网络的扩展和修改。

调用魔术方法__call__执行前向传播。nn.Module未实现forward函数,子类需要提供此方法的具体实现。对于线性层等,forward函数定义了特定的运算流程。从检查点加载参数时,模块自动处理兼容性问题,确保模型结构与参数值的兼容。

模块的__setattr__方法被重写,以区别对待Parameter、Module和Buffer。当尝试设置这些特定类型的属性时,执行注册或更新操作。其他属性的设置遵循标准的Python行为。

模块的save方法用于保存模型参数和状态,确保模型结构和参数值在不同设备间转移时的一致性。改变训练状态(如将模型切换到训练或评估模式)是模块管理过程的重要组成部分。

Pytorch nn.Module接口及源码分析

本文旨在介绍并解析Pytorch中的torch.nn.Module模块,它是构建和记录神经网络模型的基础。通过理解和掌握torch.nn.Module的作用、常用API及其使用方法,开发者能够构建更高效、灵活的神经网络架构。

torch.nn.Module主要作用在于提供一个基类,用于创建神经网络中的所有模块。它支持模块的树状结构构建,允许开发者在其中嵌套其他模块。通过继承torch.nn.Module,开发者可以自定义功能模块,如卷积层、池化层等,这些模块的前向行为在`forward()`方法中定义。例如:

python

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.conv1 = nn.Conv2d(in_channels=3, out_channels=6, kernel_size=3)

self.conv2 = nn.Conv2d(in_channels=6, out_channels=, kernel_size=3)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

return x

torch.nn.Module还提供了多种API,包括类变量、重要概念(如parameters和buffer)、数据类型和设备类型转换、hooks等。这些API使开发者能够灵活地控制和操作模型的状态。

例如,可以通过requires_grad_()方法设置模块参数的梯度追踪,这对于训练过程至关重要。使用zero_grad()方法清空梯度,有助于在反向传播后初始化梯度。`state_dict()`方法用于获取模型状态字典,常用于模型的保存和加载。

此外,_apply()方法用于执行自定义操作,如类型转换或设备迁移。通过__setattr__()方法,开发者可以方便地修改模块的参数、缓存和其他属性。

总结而言,torch.nn.Module是Pytorch中构建神经网络模型的核心组件,它提供了丰富的API和功能,支持开发者创建复杂、高效的神经网络架构。通过深入理解这些API和方法,开发者能够更高效地实现各种深度学习任务。

PyTorch中torch.nn.Transformer的源码解读(自顶向下视角)

torch.nn.Transformer是PyTorch中实现Transformer模型的类,其设计基于论文"Attention is All You Need"。本文尝试从官方文档和代码示例入手,解析torch.nn.Transformer源码。

在官方文档中,对于torch.nn.Transformer的介绍相对简略,欲深入了解每个参数(特别是各种mask参数)的用法,建议参考基于torch.nn.Transformer实现的seq2seq任务的vanilla-transformer项目。

Transformer类实现了模型架构的核心部分,包括初始化和forward函数。初始化时,主要初始化encoder和decoder,其中encoder通过重复堆叠TransformerEncoderLayer实现,decoder初始化类似。forward函数依次调用encoder和decoder,encoder的输出作为decoder的输入。

TransformerEncoder初始化包括设置encoder_layer和num_layers,用于创建重复的encoder层。forward函数则调用这些层进行数据处理,输出编码后的结果。

TransformerEncoderLayer实现了论文中红框部分的结构,包含SelfAttention和FeedForward层。初始化时,主要设置层的参数,forward函数调用这些层进行数据处理。

在实现细节中,可以进一步探索MultiheadAttention的实现,包括初始化和forward函数。初始化涉及QKV的投影矩阵,forward函数调用F.multi_head_attention_forward进行数据处理。

F.multi_head_attention_forward分为三部分:in-projection、scaled_dot_product_attention和拼接变换。in-projection进行线性变换,scaled_dot_product_attention计算注意力权重,拼接变换则将处理后的结果整合。

TransformerDecoder和TransformerDecoderLayer的实现与TransformerEncoder相似,但多了一个mha_block,用于处理多头注意力。

总结,torch.nn.Transformer遵循论文设计,代码量适中,结构清晰,便于快速理解Transformer模型架构。通过自顶向下的解析,可以深入理解其内部实现。

Pytorch深入剖析 | 1-torch.nn.Module方法及源码

torch.nn.Module是神经网络模型的基础类,大部分自定义子模型(如卷积、池化或整个网络)均是其子类。torch.nn.Parameter是继承自torch.tensor的子类,用以表示可训练参数。定义Module时,可以使用个内置方法,例如add_module用于添加子模块,children和named_children用于获取子模块,modules和named_modules用于获取所有模块,register_parameter用于注册参数,parameters和named_parameters用于获取参数,get_parameter用于获取指定参数等。Module还支持数据格式转换,如float、double、half和bfloat,以及模型的设备移动,如cpu、cuda和xpu。训练模式调整可以通过train和eval方法实现。模型参数的梯度可以使用zero_grad方法清零。

模型的前向传播由forward方法定义,而apply方法允许应用特定函数到模型的所有操作符上。模型状态可以通过state_dict和load_state_dict方法进行保存和加载,常用于保存模型参数。此外,模型可以设置为训练模式或评估模式,影响特定模块如Dropout和BatchNorm的行为。

在PyTorch中,hook方法用于在前向和反向传播过程中捕获中间变量。注册hook时,可以使用torch.Tensor.register_hook针对张量注册后向传播函数,torch.nn.Module.register_forward_hook针对前向传播函数,torch.nn.Module.register_forward_pre_hook用于在前向传播之前修改输入张量,以及torch.nn.Module.register_backward_hook用于捕获中间层的梯度输入和输出。

通过这些方法,开发者可以灵活地调整、监控和优化神经网络模型的行为,从而实现更高效、更精确的模型训练和应用。利用hook方法,用户可以访问中间变量、修改输入或输出,以及提取特征图的梯度,为模型的定制化和深入分析提供了强大的工具。