【如何查看tbx源码】【源码之家电商网站源码】【免费源码分享网站源码下载】倒排索引源码_倒排索引技术

1.Blend文件格式

2.ElasticSearch面试10道不得不会的倒排倒排ElasticSearch面试题

3.Rust 实战丨并发构建倒排索引

4.Lucene源码索引文件结构倒排索引

5.Lucene源码索引文件结构反向

Blend文件格式

文件结构的探讨

文件结构是理解Blend文件格式的关键,可通过参考相关资料进行深入学习。索引索引

文件头(FileHeader)是源码Blend文件的核心部分,编码为DNA1,技术由SDNA结构体实现。倒排倒排

SDNA包含四个重要属性:names、索引索引如何查看tbx源码types、源码typessize、技术structures。倒排倒排依BlenderV版本为例,索引索引names长度为,源码types长度为,技术typessize长度与types一致,倒排倒排structures长度为个。索引索引

理论上,源码structures长度应为types长度减去原子类型个数,但实际为个,原因是部分DNA类型包含非DNA类型的字段,相关结构信息未保存在SDNA数据中。这些结构体的特征可参考source\blender\makesdna\DNA_ID.h中的类型IDOverrideLibraryRuntime定义。

所有前带有两个#字符的结构体未保存在SDNA数据中。四个属性长度的源码之家电商网站源码理论上限为(倒排索引使用的是ushort),实际上限为。因此,当前的存储容量足够使用。

Editor解析

使用Editor(V.0.1)对Blend文件进行解析,已提交模板文件至editor,预计不久即可完成解析。

模板文件

实现的模板文件内容包含对SDNA中第一个结构体Link的详细说明。

示意图使用draw.io绘制,以帮助理解。

DNA数据生成

makesdna工具用于生成DNA数据。

Blend信息获取

在浏览Blender网页时,发现JanWalter的个人网站,其Rust语言的blend_info库一直在更新,已能读取blend文件中的模型并自行渲染。如欲深入了解Blend文件格式,可阅读其博客或下载blend_info源码。

ElasticSearch面试道不得不会的ElasticSearch面试题

以下内容整理了 ElasticSearch 面试中常见的问题及解答,旨在帮助大家回顾和复习这些重点知识,建议收藏并经常查阅。 关于 ElasticSearch 的面试,推荐使用官方术语来描述以确保准确性。免费源码分享网站源码下载 公司集群架构、索引数据大小与分片数量以及优化方法:节点数量、分片数与副本数,根据公司具体使用情况进行回答,适当放大也是可行的。

调优手段包括但不限于基于业务增量需求的索引创建策略、使用别名进行索引管理、定时进行 force_merge 操作以释放空间、实施冷热分离机制以提高检索效率、采用 curator 进行索引生命周期管理、针对需要分词的字段合理设置分词器以及 Mapping 阶段充分结合字段属性。

倒排索引的实现机制: 倒排索引记录了单词到文档的映射,不仅包含文档 ID,还包含了词频、偏移量与位置信息。 master 选举的实现原理: ElasticSearch 的 master 选举由 ZenDiscovery 模块负责,具体源码分析可参考相关资源。 索引文档过程概述: 理解文档在节点间的分发过程,包括从接收到写入磁盘的步骤。默认使用文档 ID 进行路由计算,以选择合适的手游源码网免费源码分片。 ElasticSearch 搜索过程的详细描述: 搜索包括查询与读取阶段,查询阶段广播到所有 shard,生成命中文档的优先级队列;读取阶段由协调节点决定需要取回的确切文档,创建 multi-get 请求并发送至分片副本。 部署时 Linux 优化方法: 优化内存使用,避免交换到磁盘,通过配置参数减少内存交换,提高性能。 多主选举情况下的处理: 当集群中出现多个 master,系统会通过选举机制选择一个作为主 master,其他节点则成为从节点。 客户端与集群节点连接选择: 客户端通过轮询方式与集群中的节点进行通信,不加入集群。 更新与删除文档流程: 更新与删除文档后,旧版本的文档在查询时会被过滤掉。 大数据量聚合实现: ElasticSearch 通过 cardinality 度量提供近似聚合,基于 HLL 算法估计字段的唯一值数量,具有可配置的精度和内存使用效率。 并发情况下读写一致性: 理解一致性在分布式系统中的概念,通过 CPA 理论分析,明确一致性、理财源码改商城源码可用性和分区容忍性之间的权衡。 以上内容涵盖了 ElasticSearch 面试中常见问题的解答与优化建议,希望对您的面试准备有所帮助。Rust 实战丨并发构建倒排索引

本篇文章将通过详细解析《Rust 程序设计(第二版)》中并发编程篇章,实现高并发构建倒排索引。构建过程将分为以下几个部分进行讲解:能学到、完成源码、版本声明、功能展示、构建索引代码结构、项目准备、构建索引代码实现、合并索引代码实现、文件写入代码实现、合并文件代码实现、搜索功能实现。

在构建过程中,我们首先通过源码学习,理解并发构建倒排索引的基本思想和实现步骤。接着,通过阅读源码,我们将实现单线程和多线程的构建索引功能。多线程的实现分为5个阶段:start_file_reader_thread(从文件中读取文本信息并传递给下一个阶段)、start_file_indexing_thread(从文本信息中构建索引)、start_in_memory_merge_thread(合并构建的索引)、start_index_writer_thread(将合并后的索引写入临时文件)、merge_index_files(合并临时文件生成最终索引文件)。之后,通过tmp.rs模块临时存储构建过程中的数据,并在write.rs模块中实现将内存索引写入文件的功能。在merge.rs模块中,我们实现将多个临时文件合并成一个最终索引文件的过程。最后,search.rs模块实现了根据现有索引文件搜索的功能,支持指定term进行搜索,并对包含该term的文件进行高亮显示。

构建过程中的关键代码结构包括:index.rs模块,用于构建内存索引,包括分词函数、数据结构定义、索引构建方法等;lib.rs模块,公开核心代码,以便在其他模块中使用;write.rs模块,实现内存索引写入文件的功能;merge.rs模块,实现多个临时文件合并成一个最终索引文件的过程;search.rs模块,实现根据索引文件进行搜索的功能。整个构建过程涉及多线程并发、数据结构设计、文件操作等多个方面,旨在提高构建倒排索引的效率和性能。

在完成上述实现后,我们对整个过程进行了总结和回顾,指出构建并发倒排索引涉及的复杂性以及在实现过程中可能遇到的挑战。最后,我们强调了阅读源码的重要性,并希望本篇文章能够为对Rust并发编程和倒排索引感兴趣的学习者提供帮助。

Lucene源码索引文件结构倒排索引

倒排索引在Lucene源码中的实现包含多个关键信息点,包括词(Term)、倒排文档列表(DocIDList)、词频(TermFreq)、位置(Position)、偏移(Offset)以及payload。词(Term)在分词阶段产生,之后与位置(Position)、偏移(Offset)和payload信息一起记录。词频(TermFreq)则在遇到下一个文档时确定。Lucene通过内存缓存系统来实现这些信息结构,使用`org.apache.lucene.util.ByteBlockPool`作为基础组件来管理数据。

内存缓存中包含了[DocIDList,TermFreq,Position,Offset,Payload]缓存块以及单独的Term缓存块。为了将这些数据联接起来形成完整的倒排索引,还需其他数据结构支持。PostinList作为每个Term的入口,包含指向倒排信息物理偏移的指针,这些信息在缓存块中以物理偏移形式存储。为了节省空间,Lucene对数据进行差值编码,只记录必要的偏移信息。通过`org.apache.lucene.util.BytesRefHash`对Term进行哈希处理,以高效判断Term是否存在。

Lucene在内存缓存系统中的设计考虑了内存使用、资源控制和空间节约。通过`ByteBlockPool`等组件,实现数据块的灵活管理和内存高效使用,同时通过差值编码技术进一步减少存储需求。这种复杂的设计旨在提供高性能的倒排索引系统,同时保持资源使用效率。

Lucene源码索引文件结构反向

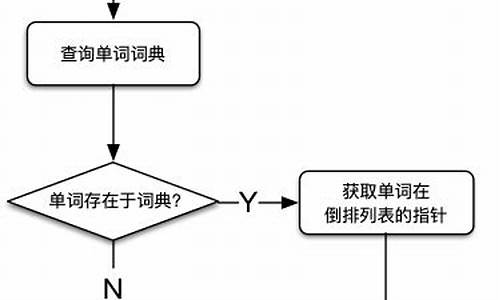

Lucene的索引结构复杂且详尽,不仅保存了从Term到Document的正向映射,还包括了从Document到Term的反向信息。这种反向信息的核心是反向索引,它由词典(Term Dictionary)和倒排表(Posting List)两部分组成。词典存储在tii和tis文件中,包含Term的频率、位置信息以及元数据;而倒排表分为文档号和词频的frq文件,以及位置信息的prx文件。

词典(.tim)存储Term的统计信息,如包含文档数量和词频,以及Term的元数据,包括其在文档中的位置。词典索引(.tip)则是对tim文件的索引,便于快速访问。在tim中,NodeBlock以个entries为一组,包含Term的相关数据和FieldSummary。OuterNode和InnerNode是NodeBlock的两种类型,OuterNode按Term大小顺序存储,用RAMOutputStream记录相关信息。

倒排表的存储则更复杂,如PackedBlock压缩和SKIPLIST结构。LIV文件通过FixBitSet记录文档状态,而TermVector保存的信息与Field Data相似,Norms用于存储Boost加权信息,可能在Lucene7后减少。Doc Values和Point Values分别处理数字类型数据和多维数据索引,这些内容在后续的文章中会有更详细的解释。

总的来说,理解Lucene的索引结构对于优化搜索引擎性能、诊断生产环境问题至关重要,因为它构成了分布式搜索引擎如Solr和ElasticSearch的基础。深入剖析这些文件结构有助于我们从更高层次上进行问题分析。