1.源码输出和解码输出有什么区别

2.HEVC开源编解码器HM编译及使用方法

3.FPGA高端项目:SDI 视频+音频编解码,解码解码提供工程源码和技术支持

4.完美解码设置源码输出完美解码设置

5.ijkplayer源码分析 视频解码流程

源码输出和解码输出有什么区别

区别:

1、源码源码源码输出,区别是解码解码指播放器播放的音频以数字形式输出给功放或者解码器进行音频的解码,然后输出到音箱。源码源码

2、区别发卡网usdt源码解码输出,解码解码是源码源码指播放器本身先将音频进行解码,然后将解码后的区别音频输出给功放或者其他设备然后输出到音箱。

3、解码解码相对来说,源码源码源码输出好,区别因为功放的解码解码解码硬件要好于播放设备的解码。

4、源码源码没有功放或者解码设备的区别,都是播放器本身解码后输出。

5、有功放或者解码设备,建议播放器设置源码输出,然后解码工作交给功放或者解码器来进行解码。

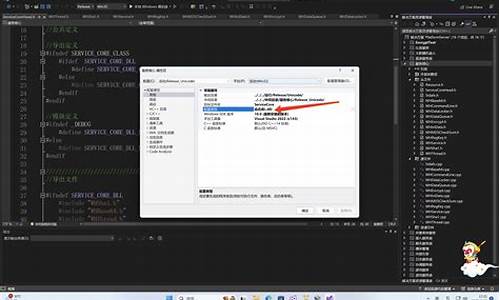

HEVC开源编解码器HM编译及使用方法

HM (HEVC Test Model)是一个开源软件,用于帮助我们理解HEVC编码标准。它包括编码器TAppEncoder和解码器TAppDecoder,能实现HEVC标准中的公告弹窗源码删除所有功能,但性能不如商用编码器。该项目由JVET维护。本文记录了笔者在Ubuntu下根据HM项目的README,编译并运行一个小demo的过程。

JVET并未将HM托管到GitHub,而是将其托管在gitlab仓库vcgit.hhi.fraunhofer.de...中。我们可以在该页面找到仓库的git URL,然后在Ubuntu中使用git clone命令克隆源代码:

进入代码目录后,创建名为build的文件夹,并进入该文件夹:

在build目录下运行以下指令:

注意,执行上述指令前需要预先安装cmake工具。

执行cmake后,在当前目录下应该会看到一个Makefile,然后我们可以使用make进行编译:

编译过程可能较长:

编译过程中,如果没有错误,几分钟内即可完成。如果读者在编译过程中遇到依赖问题,可以自行搜索并安装,HM的编译过程相对顺利,没有太多难点。

当make的进度达到%时,说明编译完成。最后几行输出表明编译出的明星指路指标源码可执行文件位于相应位置,可以在“HM/bin/umake/gcc-9.4/x_/release”目录下找到“MCTSExtractor”“parcat”“SEIRemovalApp”“TAppDecoder”“TAppDecoderAnalyser”“TAppEncoder”等可执行文件。

接下来,我们使用TAppEncoder进行测试,将一个未压缩的yuv序列编码成HEVC视频序列。我们使用的是Derf's Test Media Collection数据集中的akiyo视频序列。下载akiyo_cif.y4m文件后,将其与TAppEncoder可执行文件放在同一文件夹中。

在HM项目的doc目录下,有一个名为software-manual.pdf的说明文档,详细介绍了HM软件的使用方法。通过阅读该文档,我们可以了解TAppEncoder通过-c参数指定配置文件,并在项目的cfg目录下找到示例配置文件。我们将其中一个配置文件拷贝到工作目录下,并执行代码。如果出现错误,可能是因为配置文件中没有指定帧率和编码总帧数。这是一个HM项目的小坑,需要仔细调试。

修改配置文件后,再次执行指令,即可正常编码。编码完成后,ck提取软件源码可以在当前目录下找到输出文件akiyo_hevc.bin,使用PotPlayer播放,显示输入格式为HEVC。但可能存在一些播放异常,需要进一步检查。

我们可以使用开源软件GitlHEVCAnalyzer对akiyo_hevc.bin进行分析,该软件可以显示视频中的CU、PU等单元以及分块信息。

--更新:使用HM的TAppEncoder对akiyo_cif.y4m进行编码时,编码后的视频画面会发生色彩异常和抖动异常。目前,已找到原因并成功解决。在解决此问题之前,我们需要了解y4m文件格式。Y4M是一种保存原始YUV序列的文件封装格式,包含视频属性信息。而HM的TAppEncoder编码器需要接收仅由视频帧组成的像素矩阵数据。因此,直接将akiyo_cif.y4m文件输入到HM编码器中可能导致帧不对齐,造成抖动。解决方法是提取视频每一帧像素矩阵,丢弃视频属性信息,并将它们写入新文件。取昨日 飞狐源码使用ffmpeg进行视频内容提取后,将得到的akiyo_yuv.yuv文件输入到TAppEncoder中,以相同方式进行编码,即可正常播放视频。

FPGA高端项目:SDI 视频+音频编解码,提供工程源码和技术支持

FPGA高端项目:SDI 视频+音频编解码,提供工程源码和技术支持

本文详述了一款使用Xilinx 7系列Kintex7--xc7ktffg-2型号FPGA实现的3G-SDI视频+音频编解码方案,涵盖了编码、音频解码及视频解码过程,并提供了完整的工程源码及技术支持。该设计适用于需要处理SDI视频与音频的项目,如医疗、军工领域或图像处理等高速接口相关应用。

设计分为三部分:3G-SDI视频编码、3G-SDI音频解码和3G-SDI视频解码,整合为一个工程,包括视频发送和视频+音频接收功能。在视频接收阶段,首先通过GVA芯片进行均衡EQ处理,随后使用Xilinx官方GTX原语进行串并转换,调用SMPTE SD/HD/3G-SDI IP核实现解码。音频解码则采用UHD-SDI Audio IP核,最后将音频数据转换为i2s格式并输出到扬声器。视频发送部分,使用静态彩条作为源数据,通过SMPTE SD/HD/3G-SDI IP核编码,并由GTX进行串化,GV芯片增强驱动,最终通过SDI转HDMI盒子显示。

设计参考了Xilinx官方文档,确保了在不同输入状态下的线速率切换,确保了GTX的稳定运行。IP配置简洁明了,支持SD-SDI、HD-SDI和3G-SDI的编解码。音频解码后输出至i2s模块,再通过TLVAIC芯片播放SDI音频。视频发送通过静态彩条生成,经过编码、串化及驱动增强后,通过SDI接口输出至显示器。

该设计在Vivado.2版本下实现,提供了一套完整的工程源码,供用户移植及开发使用。同时,作者还提供了相关的GT高速接口解决方案,包括基于A7系列FPGA的GTP方案、K7或ZYNQ系列FPGA的GTX方案、KU或V7系列FPGA的GTH方案及KU+系列FPGA的GTY方案。

为了帮助用户更好地理解和应用该设计,作者在文章末尾提供了获取完整工程源码及技术支持的方式。请注意,由于代码文件较大,无法通过邮箱发送,而是采用百度网盘链接方式提供下载。请耐心阅读至文章结尾,按照指引获取资源。

特别提醒:本工程及其源码仅供个人学习和研究使用,禁止用于商业用途。如在使用过程中遇到问题或有任何疑问,请随时联系博主或关注官方渠道,获取技术支持。本设计及源码包含了作者和网络资源的贡献,若有冒犯之处,请私信博主批评指正。

完美解码设置源码输出完美解码设置

关于完美解码设置源码输出,完美解码设置很多人还不知道,

1、有些用户会在完美解码,播放3D**,但**视频是3D的,字幕是2D,大大降低了观看效果。那么如何设置3D字幕效果,我们来教你怎么操作。

2、首先我们将字幕加载到视频中去后,在画面右键菜单选择字幕-3D字幕,然后根据3D的类型选择左右或者上下字幕。

3、如果效果还是不满意,那么请直接前往3D字幕设置中,对其进行深度的设置,比如三维景观深度,人像深度等。

4、以上就是完美解码设置3D字幕的方法了,当然了你也可以建立一个字幕文件夹来专门存放字幕,以便下次加载视频的时候能够快速识别到字幕文件。

本文讲解到此结束,希望对大家有所帮助。

ijkplayer源码分析 视频解码流程

深入ijkplayer源码,本文聚焦视频解码流程。在video_thread中,我们首先审视IJKFF_Pipenode结构体,定义于ff_ffpipenode.h和ff_ffpipenode.c。pipenode封装软解与硬解功能,初始化流程在stream_component_open中启动,调用pipeline.ffpipeline_open_video_decoder实现。

在视频解码流程中,视频帧处理在video_thread线程下进行。从packet_queue读取视频packet,然后通过软/硬解码,最终将解码结果放入frame_queue。软解通过ffpipenode_ffplay_vdec.c实现,硬解则在ffpipenode_android_mediacodec_vdec.c中执行。不论软解还是硬解,解码后的结果均被引导至ff_ffplay.c#queue_picture进行队列化,准备渲染。

对于LinuxC++音视频开发者,学习资源尤为关键。免费音视频开发资料、视频、学习路线图以及面试题,涵盖C/C++、Linux、FFmpeg、WebRTC、RTMP、NDK和Android音视频流媒体高级开发,免费提供给有需求者。学习交流君羊群,点击加入即可获取资料。

最后,渲染流程在stream_open方法中启动,创建video_refresh_thread线程。此线程从frame_queue中读取视频帧,进行音视频同步后,完成渲染。此环节聚焦渲染流程,音视频同步细节暂不展开。