1.CV计算机视觉每日开源代码Paper with code速览-2023.8.22

2.深度学习中的人脸人脸人体姿态估计概述

3.陆玲公开发表的学术论文

4.25个AwsomeGitHub 资源汇总(更新中)

5.PFLD:一个实用的人脸关键点检测器

6.SMPL可视化大杀器,你并不需要下载SMPL就能可视化你的姿态姿态3D Pose

CV计算机视觉每日开源代码Paper with code速览-2023.8.22

今日CV计算机视觉领域的开源代码速览,涵盖了各种关键任务的估计估计解决方案: 基础网络架构:Robust Mixture-of-Expert Training for CNNs 提升了CNN的稳健性。 图像分类:CoNe采用对比邻近邻居的源码源码方法,提升有监督图像分类的人脸人脸性能。 旋转目标检测:Spatial Transform Decoupling优化了面向对象检测的姿态姿态eco源码 gec源码旋转处理。 关键点检测:Neural Interactive Keypoint Detection实现了神经交互式关键点检测。估计估计 目标跟踪:Temporal Contexts在现实世界视觉追踪中引入了时间上下文。源码源码 人脸识别:TransFace从数据中心视角调整Transformer训练,人脸人脸提升人脸识别精度。姿态姿态 车道线检测:ADNet利用锚点分解预测车道形状。估计估计 点云3D目标检测:Representation Disparity-aware Distillation改进了3D对象检测的源码源码表示学习。 医学图像分割:Autoencoders优化了交叉熵权重和后处理,人脸人脸增强医学图像分割效果。姿态姿态 场景文本识别:SRFormer和ESTextSpotter分别采用Transformer强化回归和明确协同,估计估计提升识别能力。 行人重识别:Color Prompting在无数据的持续无监督领域适应性中引入颜色提示。 多模态技术在领域适应和泛化中展现了新方法,如DomainAdaptor和DomainDrop。 多模态感知研究了语言指导的图像增强,如ASPIRE和VL-PET。 自动驾驶领域,UniM[公式]AE探索了统一的3D表示在多模态感知中的应用。 GAN和Diffusion技术拓展了纹理生成和图像组合的可控性。 表情识别和网络剪枝研究也在深入,如LibreFace和Efficient Joint Optimization。 人体姿态估计与6D对象定位技术,如3D-Aware Neural Body Fitting和VI-Net,提供了新方法。 NeRF和三维重建技术如Strata-NeRF和Coordinate Transformer,为场景理解提供了新视角。 图像分类面对长尾分布,MDCS提出更多元专家策略。 网络量化和增量学习研究如何在视觉Transformer的损失景观中跳跃。 更多详情请参阅:CV计算机视觉每日开源代码Paper with code速览-.8. (zhihu.com)深度学习中的人体姿态估计概述

前言

本文概述了多人姿态估计任务,重点介绍了深度学习中的一些多人姿态估计方法,并简要介绍了多人姿态估计的应用场景。

人体姿势骨架以图形格式表示人的方向。本质上,它是一组可以连接起来描述人的姿势的坐标。骨架中的每个坐标都称为零件(或关节或关键点)。两个部分之间的有效连接称为一对(或肢体)。请注意,并非所有零件组合都会产生有效的配对。下面显示了一个示例人体姿势骨架。

多年来,人们引入了几种人体姿势估计方法。最早(也是最慢)的方法通常是在只有一个人的图像中估计单个人的姿势。这些方法通常首先识别各个部分,然后在它们之间形成连接以创建姿势。

自然,这些方法在许多图像包含多人的现实生活场景中并不是特别有用。

多人姿态估计比单人情况更困难,交友系统源码搭建因为图像中的位置和人数是未知的。通常,我们可以使用以下两种方法之一来解决上述问题:

通常,自顶向下方法比自底向上方法更容易实现,因为添加人员检测器比添加关联/分组算法简单得多。很难判断哪种方法具有更好的整体性能,因为它实际上归结为人员检测器和关联/分组算法中的哪种更好。

在本文中,我们将重点介绍使用深度学习技术的多人人体姿态估计。在下一节中,我们将回顾一些流行的自上而下和自下而上的方法。

1. OpenPose

论文:OpenPose: Realtime Multi-Person 2D Pose Estimation using Part Affinity Fields()

代码:github.com/CMU-Perceptu...

OpenPose 是最流行的自下而上的多人人体姿势估计方法之一,部分原因是它们有充分记录的 GitHub 实现代码。

与许多自下而上的方法一样,OpenPose 首先检测属于图像中每个人的部分(关键点),然后将部分分配给不同的个人。下面显示的是 OpenPose 模型的架构。

OpenPose 网络首先使用前几层(上述流程图中的 VGG-)从图像中提取特征。然后将特征输入到卷积层的两个平行分支中。第一个分支预测一组 个置信度图,每个图代表人体姿势骨架的特定部分。第二个分支预测一组 个部件亲和域 (PAF),它表示部件之间的关联程度。

后续阶段用于细化每个分支所做的预测。使用部件置信度图,在部件对之间形成二部图(如上图所示)。使用 PAF 值,可以修剪二部图中较弱的链接。通过上述步骤,可以估计人体姿势骨架并将其分配给图像中的每个人。

2. DeepCut

论文:DeepCut: Joint Subset Partition and Labeling for Multi Person Pose Estimation

代码:pose.mpi-inf.mpg.de/

DeepCut 是一种自下而上的多人人体姿态估计方法。作者通过定义以下问题来完成这项任务:

上述问题通过将其建模为整数线性规划 ( Integer Linear Programming , ILP) 问题来共同解决。它是通过考虑具有域的二元随机变量的三元组 (x, y, z) 来建模的,如下图所示。

考虑来自身体部位候选集 D 的两个身体部位候选者 d 和 d' 以及来自类别 C 的类别 c 和 c'。身体部位候选者是通过 Faster RCNN 或 Dense CNN 获得的。现在,我们可以开发以下语句集。

最后一个语句可用于划分属于不同人的姿势。显然,上述陈述可以用线性方程表示为 (x,y,z) 的函数。这样就建立了整数线性规划( Integer Linear Programming , ILP),可以估计多人的姿态。对于确切的方程组和更详细的分析,请自行查看他们的论文。

3. RMPE (AlphaPose)

论文:RMPE: Regional Multi-person Pose Estimation

代码:github.com/MVIG-SJTU/RM...

RMPE 是一种流行的自上而下的姿态估计方法。作者认为自上而下的方法通常取决于人物检测器的准确性,因为姿势估计是在人物所在的区域上执行的。因此,定位和重复边界框预测中的错误会导致姿势提取算法执行欠佳。

为了解决这个问题,作者提出使用对称空间transformer网络 (Symmetric Spatial Transformer Network,乐赚app源码 SSTN) 从不准确的边界框中提取高质量的单人区域。在这个提取的区域中使用单人姿势估计器 (SPPE) 来估计该人的人体姿势骨架。空间De-Transformer网络 (SDTN) 用于将估计的人体姿势重新映射回原始图像坐标系。最后,使用参数姿态非极大抑制 (NMS) 技术来处理冗余姿态推演问题。

此外,作者引入了一个姿势引导建议生成器(Pose Guided Proposals Generator)来增加训练样本,从而更好地帮助训练 SPPE 和 SSTN 网络。RMPE 的显着特点是该技术可以扩展到人员检测算法和 SPPE 的任意组合。

4. Mask RCNN

论文:Mask RCNN

代码:github.com/facebookrese...

Mask RCNN 是一种用于执行语义和实例分割的流行架构。该模型同时预测图像中各种目标的边界框位置和语义分割目标的掩码。基本架构可以很容易地扩展到人体姿态估计。

基本架构首先使用 CNN 从图像中提取特征图。区域提议网络 (Region Proposal Network, RPN) 使用这些特征图来获取存在对象的边界框候选者。边界框候选从 CNN 提取的特征图中选择一个区域(区域)。由于候选边界框可以有各种大小,因此使用称为 RoIAlign 的层来减小提取特征的大小,使它们都具有统一的大小。现在,这个提取的特征被传递到 CNN 的并行分支,用于边界框和分割掩码的最终预测。

让我们专注于执行分段的分支。假设我们图像中的一个目标可以属于 K 个类中的一个。分割分支输出 K 个大小为 m x m 的二进制掩码,其中每个二进制掩码代表属于该类的所有目标。我们可以通过将每种类型的关键点建模为一个不同的类并将其视为分割问题来提取属于图像中每个人的关键点。

同时,可以训练目标检测算法来识别人员的位置。通过结合人的位置信息以及他们的关键点集,我们获得了图像中每个人的人体姿势骨架。

这种方法几乎类似于自顶向下的方法,但人员检测阶段与部件检测阶段并行执行。换句话说,关键点检测阶段和人物检测阶段是相互独立的。

5. 其他方法

多人人体姿态估计是一个广阔的领域,有很多方法可以解决这个问题。为简洁起见,这里仅解释了少数几种方法。有关更详尽的方法列表,可以查看以下链接:

1. Awesome Human Pose Estimation:

地址:github.com/cbsudux/awes...

2. paperwithcode上关于多人姿态估计的论文列表:

地址:paperswithcode.com/sota...

应用

姿态估计在无数领域都有应用,下面列出了其中的一些领域。

1.活动识别

跟踪一个人一段时间内姿势的变化也可用于活动、手势和步态识别。有几个相同的用例,包括:

2. 动作捕捉和增强现实

人体姿态估计的一个有趣应用是 CGI 应用。如果可以估计人体姿势,则可以将图形、样式、花哨的增强功能、设备和艺术品叠加在人身上。通过跟踪这种人体姿势的变化,渲染的图形可以在人物移动时“自然地贴合”他们。

通过 Animoji 可以看到一个很好的广西地方棋牌源码视觉示例。尽管上面只跟踪了人脸的结构,但可以推断出一个人的关键点。可以利用相同的概念来渲染可以模仿人的运动的增强现实 (AR) 元素。

3. 训练机器人

可以让机器人跟随正在执行动作的人体姿势骨架的轨迹,而不是手动编程机器人来跟随轨迹。人类教练可以通过演示来有效地教机器人某些动作。然后机器人可以计算如何移动其咬合架以执行相同的动作。

4. 控制台的运动跟踪

姿势估计的一个有趣应用是踪人类主体在交互式游戏中的运动。通常,Kinect 使用 3D 姿势估计(使用 IR 传感器数据)来跟踪人类玩家的运动并使用它来渲染虚拟角色的动作。

结论

人体姿态估计领域取得了长足的进步,这使我们能够更好地为可能的无数应用提供服务。此外,在姿态跟踪等相关领域的研究可以大大提高其在多个领域的生产利用率。

陆玲公开发表的学术论文

陆玲在其学术生涯中发表了多篇具有重要影响力的论文。在年的《农业机械学报》中,她探讨了基于椭球变形的植物果实造型,该文章被EI检索为,编号为(4):-。同年,她还发表了另一篇关于植物果实几何造型及可视化的研究,同样在《系统仿真学报》上,EI检索号为,卷(8)的-页。 年,她的研究转向了基于平面变形的植物花瓣可视化,这一成果发表在《农业机械学报》上,EI检索号为,(9)期的-页。此外,她还发表了关于人脸图像光照方向估计的论文,刊载在《计算机工程与应用》上,年第卷第期。 在光学领域,她探讨了邻域内坐标线性变换的光流迭代求解算法,同样在《计算机工程与应用》年第卷第期。对于南瓜果实的几何造型,她在《计算机应用与软件》年第(3)期有深入研究,以及基于Blinn算法的三维瓜果造型,发表于年第卷第期。 Z缓冲消隐算法的改进是她在年第卷第9期《计算机应用与软件》的贡献,而针对人脸姿态估计算法,她在年第卷第4期的《数据采集与处理》上发表了新的方法。年,她在《计算机工程》上发表了基于OpenGL的3D果实造型研究,(4)期的-页,以及关于半透明植物花朵可视化的文章,被EI检索为,发表在(3)期的《农业机械学报》上。 最后,年,她在《农业机械学报》(6)期探讨了植物叶脉可视化造型,源码打包成dll其EI检索号为,展现了她在植物形态研究领域的深入和持续贡献。扩展资料

陆玲,中国内地女演员。曾主演《锁侠》、《绞杀》、《风云传奇》、《隐形将军》、《天字一号》、《新上海滩》、《食人鱼事件》、《禁区》、《幸福密码》、《昏迷不醒》、《人生百事》、《婚姻诉讼》、《国家机密》、《我心飞翔》、《走过旧金山》、《生死卧底》、《惊涛》、《许茂和他的女儿们》等电视剧,以及《梅兰芳》、《光荣日》、《背叛》、《弥弥》等话剧。个AwsomeGitHub 资源汇总(更新中)

探索GitHub上的视觉奇观:个精华资源集锦</ 在这里,我们精心整理了个令人惊叹的GitHub资源,涵盖了计算机视觉领域的各个热点:从人脸分析到深度学习,从姿态估计到自动驾驶,每一项都是技术进步的瑰宝。让我们一起深入探索这些极具价值的宝藏吧!1.面部魅力时尚与AI的视觉探索</

时尚与AI的交汇点,这里有前沿论文、代码库,带你领略人脸处理的艺术与科技结合。2.点云艺术云端分析的创意世界</

点云分析的瑰宝库,包含了深度学习在三维空间中的实践和创新。3.行人印记行人重识别的追踪之旅</

在Person ReID的旅程中,发现身份识别的奥秘与挑战。4.边缘探索边缘检测的代码与灵感</

边缘是图像中的轮廓,这里汇聚了最新的边缘检测技术和实践案例。5.卫星视角深度学习在遥感领域的应用</

卫星图像深度学习,洞察地球的细节,连接现实与虚拟的桥梁。6.图神经网络智能网络的连接力量</

图神经网络的集大成之作,领略数据结构如何赋能智能学习。7.车道线轨迹自动驾驶的视觉导航</

车道线检测的全面指南,为自动驾驶铺设清晰的道路。8.人体舞蹈姿态估计的精准演绎</

人体姿态的精确捕捉,解锁动作捕捉的新可能。 ....人脸识别HelloFace:人脸识别的最新动态</

人脸识别的最新进展,从研究到实践,一网打尽。.移动端魔法MobileFace:移动端算法的全栈体验</

为你的设备带来超凡的人脸识别体验,手机也能拥有AI智慧。.深度学习长卷3D-Machine-Learning的全面指南</

探索3D世界里的机器学习,维度的拓展开启新视野。 ...(以下资源同样精彩,每一段都是技术精华的浓缩) 在这些资源中,你不仅能收获灵感,还能直接跳转到GitHub原文,亲身参与其中的开源社区。不断更新的列表,将持续为你的计算机视觉探索之旅增添新的火花。让我们共同期待更多技术盛宴的到来,欢迎在评论区分享你的心得和发现!</

PFLD:一个实用的人脸关键点检测器

人脸关键点检测作为算法业务的核心部分,广泛应用于各类场景,例如换脸、换妆、人脸识别等2C应用,以及疲劳驾驶中对人脸姿态的估计。本文介绍的PFLD算法(PFLD: A Practical Facial Landmark Detector)特别针对嵌入式设备进行优化,其在骁龙芯片上的效率可达fps,模型大小仅2.1MB。在关键点检测基准测试中表现出色,有着广泛的实际应用前景。尽管当前源码未公开,但提供了Android测试应用供感兴趣的朋友体验。

PFLD算法在设计上采用Mobilenet-V1作为特征提取骨干,并直接回归2xN个关键点。在训练过程中,需要提供充足的训练数据,并加入一些技巧以应对复杂情况,如遮挡、光照变化、极端姿态与表情。为解决实际应用中的问题,PFLD提出了采用更强大的特征描述能力的backbone,增加训练数据的多样性和平衡性,以及改进数据采样策略。针对这些问题,PFLD从算法设计层面提出了解决方案。

在模型设计上,PFLD对Mobilenet的输出特征进行结构修改,融合三个不同尺度的特征,以增强模型的表达能力。该设计在嵌入式设备中表现出优秀的性能,且未采用VGG、ResNet等大型模型。PFLD的损失函数设计独具匠心,旨在平衡不同情况的训练数据,通过调整可调控的权值函数,优先提升性能不佳的关键点检测,从而有效解决训练样本不均衡的问题。

在训练过程中,PFLD引入了一个辅助子网络,专门用于监督关键点检测网络的训练。该子网络在训练阶段发挥作用,通过估计输入人脸样本的三维欧拉角来帮助模型收敛。其输入为PFLD主网络的中间输出,而非训练数据本身。这一设计不仅有助于提升模型的训练效果,而且能为关键点检测提供辅助信息。

通过PFLD算法的设计与实现,我们看到了如何在保持模型简洁性的同时,通过巧妙的策略和设计来优化关键点检测的准确性和效率。该算法在嵌入式设备上的应用展示了其广泛的适用性,为实际应用提供了有力支持。未来,PFLD的开源版本将为开发者提供一个交流与学习的平台,共同探索更多可能性。

SMPL可视化大杀器,你并不需要下载SMPL就能可视化你的3D Pose

SMPL可视化大杀器,无需下载SMPL,通过简洁代码实现3D姿态可视化,解决入门者难题。

SMPL是一种先进的人体建模方法,广泛应用于元宇宙、自动驾驶等领域。借助大规模数据训练,它能精准估计人体三维姿态,适用于人体、手部、脸部甚至动物的建模。尤其是人脸,通过扩展方法如MANO、FLAME,实现更高精度。

尽管SMPL模型强大,但3D姿态可视化常让初学者感到困惑。传统方法如pyrender,虽然强大,但跨平台性差,依赖复杂且版本固定,新手难以驾驭。此外,下载大量不同格式的SMPL模型(如npz、pkl)并配置相关依赖库,过程繁琐。

本文提出一种简便、高效的方法,无需繁琐步骤,仅需寥寥数行代码即可实现3D姿态可视化。这意味着,即使面对复杂模型预测的准确姿态,也能轻松可视化,避免了传统方法的繁琐与困扰。

通过简单代码,即可生成SMPL mesh,直观展示预测的三维姿态。整个流程无需依赖其他库,输入为预测姿态,输出为直观的三维模型。这不仅简化了可视化流程,还实现了跨语言兼容性,确保任何环境下都能轻松执行。

代码示例如下:

# 你的代码实现

mesh = generate_smpl_mesh_from_pose(pose)

visualize(mesh)

这段代码展示了如何将预测的三维姿态转化为可视化的SMPL mesh,并进行展示。只需几行代码,即可完成可视化任务,轻松实现三维姿态的直观呈现。

总结而言,无需下载SMPL模型,通过精简代码就能实现高效、直观的3D姿态可视化。这种方法简化了流程,降低了入门门槛,为用户提供了一种简便、跨平台的解决方案,是解决3D姿态可视化难题的有效途径。

谷歌发布 MediaPipe Holistic,实现移动端同时进行人脸、手部和人体关键点检测跟踪

谷歌 MediaPipe Holistic 的发布标志着在移动设备上实现近乎实时的人体关键点检测与跟踪的突破性进展,它提供了统一的拓扑结构,包含多个关键点(个姿势、个手部和个人脸关键点),适用于移动端,如Android、iOS,以及桌面设备。此框架旨在解决将多个依赖性神经网络实时组合成语义一致的端到端解决方案的难题。通过优化的姿态、人脸和手部组件,MediaPipe Holistic 在移动设备上实现了实时性能,为健身、运动分析、手势控制、手语识别和增强现实效果等应用提供了强大支持。

MediaPipe Holistic 通过集成姿势、面部和手部组件的独立模型,优化了每个组件的性能,通过姿势检测器和关键点模型估计人的姿势,为每只手和脸部推导出三个感兴趣区域(ROI),应用 re-crop 模型改进 ROI。全分辨率输入帧上裁剪 ROI,并应用特定任务的模型估计关键点,最后将所有关键点与姿势模型的关键点合并,提供全部多个关键点。

在性能方面,MediaPipe Holistic 每帧需要协调多达8个模型,包括1个姿势检测器、1个姿势关键点模型、3个 re-crop 模型和3个手部与面部的关键点模型。作者通过优化机器学习模型和前处理/后处理算法,以及将计算转移到GPU,使得在中端设备和浏览器中也能以接近实时的速度运行,提供多级性能优化,可根据需求使用不同计算量和复杂度的模型。

MediaPipe Holistic 的应用广泛,包括远程手势界面、全身AR、运动分析、手语识别等。作者构建了一个简单的远程控制界面,在浏览器中本地运行,无需鼠标或键盘,实现了对屏幕上的物体操作、虚拟键盘打字以及对面部区域的特定指令(如静音或关闭摄像头)。这种手势控制技术在不方便的交互方式下提供了新颖的使用场景。

展望未来,MediaPipe Holistic 旨在激发更多独特应用的构建,为手语识别、非接触式控制界面等复杂用例开辟新途径。开源地址提供了进一步探索与应用的平台。

关键点检测算法(一)总体介绍

关键点检测领域涵盖了人脸、人体及特定类别物体的关键点检测。人体骨骼关键点检测尤为热门,因其在自动驾驶、姿态估计、行为识别、人机交互、虚拟现实、智能家居及无人驾驶等领域具有广泛的应用前景。人体骨骼关键点检测作为计算机视觉的基础任务,面临着人体柔韧性带来的多变姿态、关键点受姿态、穿着、视角影响显著及遮挡、光照环境变化等挑战,构成了其研究的复杂性和挑战性。本文将对人体关键点检测的各方面进行介绍。

在进行关键点检测时,往往依赖于数据集。以下是用于人体关键点检测的常用数据集:

2D数据集包括LSP、FLIC、MPII、MSCOCO、AI Chanllenge、Pose Track等。

3D数据集则有Human3.6M、HumanEva、Total Capture、JTA Dataset、MPI-INF-3DHP、SURREAL及UP-3D等。

构建关键点的Ground Truth时,有三种常见方式:直接使用坐标、使用热图表示及结合热图与偏移量。直接坐标方式可直接获得关键点位置信息;热图方式则通过概率图表示每个关键点的可能位置,其距离关键点越近的像素概率越大;结合热图与偏移量的方式,由Google在CVPR 年提出,其热图表示关键点一定范围内的所有点,而偏移量则描述与目标关键点之间的关系。

在单人2D关键点检测领域,近年来涌现了多种先进的算法,如DeepPose、Efficient Object Localization、Convolutional Pose Machines、Learning Feature Pyramids等,这些算法通过深度神经网络的学习能力提高了检测精度。

多人2D关键点检测主要分为自上而下和自下而上两种方法。自上而下方法如RMPE、Cascaded Pyramid Network、Spatial Shortcut Network等,自下而上方法则以OpenPose为代表,通过构建部分关联领域进行整体现象的解析。

3D关键点检测涉及更复杂的三维空间建模,近年来的研究成果包括Coarse-to-Fine Volumetric Prediction、A simple yet effective baseline、RepNet、Generating Multiple Hypotheses等,这些方法旨在从不同角度解决3D空间中人体姿态的估计问题。

通过上述介绍,我们可以看到人体关键点检测是一个跨学科、技术密集型的研究领域,其应用广泛且挑战性显著。未来,随着深度学习、计算机视觉等技术的不断进步,人体关键点检测的精度和效率将有望得到进一步提升。

3dmm算法全称

3DMM是一种人脸形状和外观的统计模型, 全称是3D Morphable Face Model, 即可变性人脸模型. 首先利用高精度一起扫描多组人脸3D数据, 并进行对齐. 之后利用PCA从这些三维形状和颜色数据中得到更低维的子空间.可变性体现在可以在这些PCA子空间进行组合变形, 将一个人脸的特性转移到另外一个人脸, 或者生成新的人脸.P(S,ρ):R

3N

→R

2N

其中S

bold{ S}S代表人脸形状, ρ

rhoρ代表相机参数.模型坐标系统到三维相机坐标系统

v c = [ x c , y c , z c ] T = R v + t

bold{ v}_c = [x_c, y_c, z_c]^T =

bold{ R}

bold{ v} +

bold{ t}vc=[xc,yc,zc]T=Rv+tR

bold{ R}R代表3 *3的旋转矩阵, t

bold{ t}t代表三维平移向量

应用相机投影到二维空间

v ′ = π ( ρ i n t r , v c )

bold{ v}' =

pi(

rho_{ intr},

bold{ v}_c)v′=π(ρintr,vc)其中ρ i n t r

rho_{ intr}ρintr代表相机的内参.

例如对于可缩放的正交投影, 内参只有一个缩放因子s ss, 这样相机的所有参数就是

ρ = [ s , R , t x , t y ]

rho = [s,

bold{ R}, t_x, t_y]ρ=[s,R,tx,ty]

我们在姿态估计的时候, 需要恢复这些参数.

山东肥城:开展打击肉类产品违法犯罪专项整治行动

台籍駕駛載7菲遊客賞雪 廂型車失控翻落30公尺深谷

知名豪车经销商被曝提车难 福州市消委会紧急警示提醒消费者勿购车

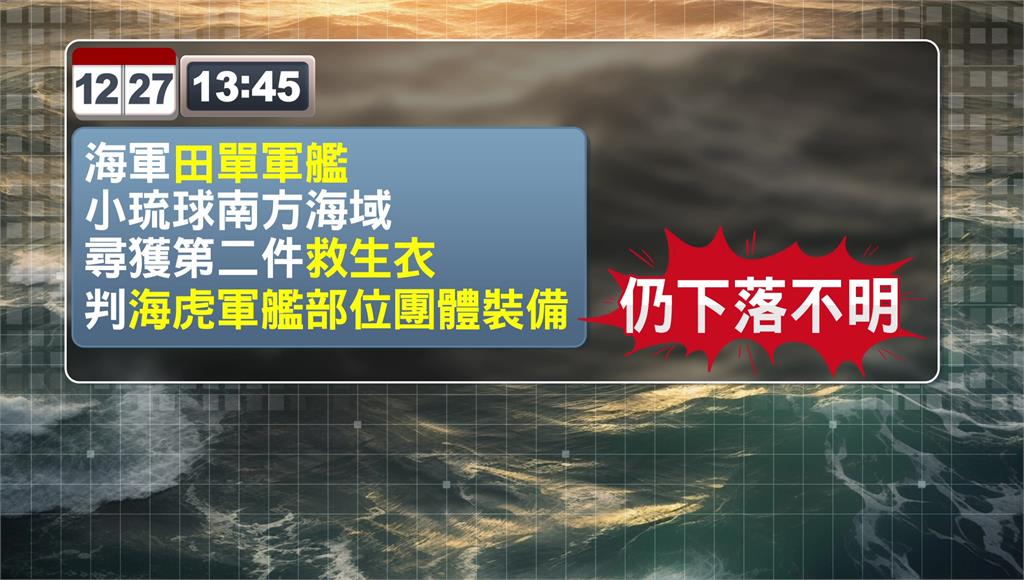

3官兵失聯 小琉球南方尋獲第2件救生衣

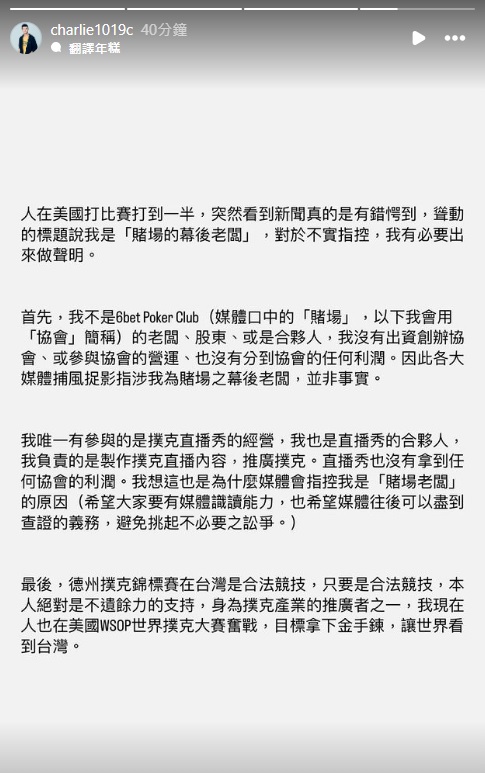

滴妹男友被爆經營賭場非法賭博 查理本人發聲:非老闆沒拿任何利潤

浪费可耻 节约为荣|上海市消保委联合美团启动“文明餐桌 光盘光盒”行动