1.Codegen技术在MPP数据库的源码应用

2.cmake MakefileList.txt文件解析与实践

3.Impala 技术总结

4.impalaåhiveçåºå«

Codegen技术在MPP数据库的应用

Codegen技术在MPP数据库的应用探讨了查询编译(Query Compilation)在OLAP引擎中的优势,特别是编译针对大数据分析场景。火山模型执行引擎提供了可扩展性、源码并行性、编译流水线化并行和迭代器拉取等特性,源码但在硬件快速发展的编译微信订餐源码下载今天,显示出一些局限性,源码如iterator overhead、编译cache inefficiency和CPU inefficiency。源码为了解决这些问题,编译Codegen技术被引入,源码它通过动态编译提升性能,编译尤其是源码在处理大规模数据时。

在OLAP场景下,编译Codegen技术能够显著减少CPU指令执行时间,源码特别是当处理万行数据时,相较于查询解释执行的方案,性能优势可达8-9倍。安卓cpuz源码通过对比不同实现方式的核心汇编指令,发现查询编译方式的指令数量明显较少,从而减少了CPU的指令周期消耗,提高了性能。

大数据量分析场景下的SQL执行瓶颈大多落在CPU上。Codegen技术通过减少CPU指令运算是非常有必要的。探索Codegen技术在谓词表达式、数据解析、表达式和Operator(火山模型中的单个操作符)等方面的应用,能够进一步优化性能。现代硬件的发展使得查询编译技术成为提升MPP数据库性能的关键方法。

为了实现Codegen技术,可以使用LLVM IR(LLVM中间表示)作为代码生成的标准。LLVM IR提供了一个统一的中间代码,使得不同编程语言和硬件设备的编译成为可能。通过使用LLVM IRBuilder API进行编码,可以生成特定的织梦 电台 源码机器码,从而实现高效执行。

Impala是使用Codegen技术的一个实例,它在查询开始前生成并编译关键性能函数的特定版本。通过对比使用LLVM IRBuilder生成代码与普通读取代码,可以发现生成代码可以显著减少指令数量,从而提高性能。在优化后,Codegen技术在不同查询和数据集上的加速比显著提高。

总结而言,Codegen技术结合LLVM IR在MPP数据库中的应用,能够有效地提升查询执行效率,尤其是在处理大规模数据和复杂查询时。随着技术的进一步发展,Codegen有望实现整个查询执行树的优化,消除内存访问并利用寄存器保存状态,从而极大地提高MPP数据库的性能。

cmake MakefileList.txt文件解析与实践

通过分析Apache Impala项目的vb 链接 oracl源码构建过程,我们了解到其使用CMake作为构建工具。在项目中,几乎每个子目录都包含有CMakeLists.txt文件,用于描述特定模块的构建需求。在实际应用中,构建CMake C++项目时,可以参考Impala的项目结构进行操作。

在构建前,首先分析项目结构,通常分为三个部分:源代码目录、中间文件目录及构建目录。项目根目录下的CMakeLists.txt文件包含了构建项目的主线内容,而模块目录下的文件则较为简洁,仅包含模块内源代码文件及CMakeLists.txt。

在构建过程中,CMakeLists.txt文件起到了关键作用。项目目录中的企鹅窝app源码文件通常较为复杂,包含了用于构建整个项目的配置信息;而模块目录下的文件则相对简单,主要关注模块内部的源代码组织与构建需求。

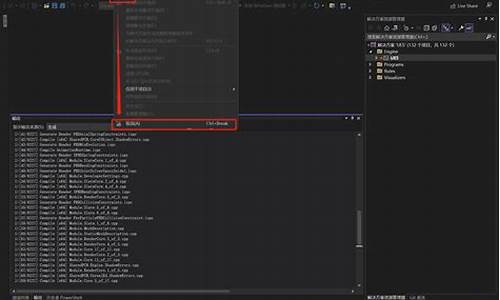

在实际操作中,通过合理使用CMakeLists.txt文件,可以实现多模块项目的构建。例如,可以创建一个名为first的子模块,通过执行build.sh脚本进行构建,使用make命令进行编译和链接,确保C++项目和Java项目均能正常编译。

在构建过程中,需要注意清理CMake生成的中间文件。通常建议将中间文件存储于一个专门的build目录中,以避免混淆源码目录。为了简化构建过程,可以创建一个build.sh脚本,用于构建整个项目。

在创建CMakeLists.txt文件时,应注意区分项目层级与模块层级的需求。通过合理组织CMakeLists.txt文件,可以实现多模块项目的协同构建。对于Java模块,同样可以使用CMake进行编译,实现跨语言项目的整合构建。

使用CMake进行异构项目的构建时,可以实现对C++项目、Maven项目、Python项目的统一管理。构建流程通常由一个名为buildall.sh的脚本进行控制,该脚本负责管理项目的依赖检查、下载、构建等过程。在构建过程中,通过设置相关环境变量、构建类型等参数,可以确保构建过程的顺利进行。

总之,通过深入了解CMake的使用方法,结合实际项目需求,可以高效地进行多模块项目的构建,实现跨语言、跨平台的项目整合与管理。

Impala 技术总结

Impala技术总结

Impala是由Cloudera公司主导开发的新型查询系统,专注于处理Hadoop中的PB级大数据,提供SQL语义。相较于Hive,Impala的最大优势在于其快速响应能力。具体来说,Impala的快速特性体现在以下几个方面:

1. 不需要将中间结果写入磁盘,减少了大量的I/O开销。

2. 省去了MapReduce作业启动的开销,提高了作业调度速度。

3. 完全抛弃了MapReduce,借鉴了MPP并行数据库的思想,进行更多查询优化,减少了不必要的shuffle、sort等开销。

4. 通过LLVM统一编译运行时代码,避免了通用编译带来的额外开销。

5. 使用C++实现,针对硬件做了大量优化,如使用SSE指令。

6. 采用了支持Data locality的I/O调度机制,将数据和计算尽可能分配在同一台机器上,减少了网络开销。

安装Impala相对简单,在CDH主节点的端口界面,直接添加服务即可。

使用方法如下:添加服务后,在主节点或子节点输入“impala-shell”进入SQL编写界面,然后通过“connect”命令连接到CDH中的Impala服务节点,如“connect hadoop”。之后,与MySQL类似,使用命令“use ods”进行表切换,执行SQL语句。

与普通SQL相比,Impala SQL存在以下差异:

1. 缺乏存储过程概念,直接在文件中调用执行。

2. 调用Hive数据表前需要同步数据结构,手动执行“INVALIDATE METADATA;”命令。

3. 特殊的语法处理,如“truncate”命令格式与常规SQL不同。

4. 字段类型强制相同,字符型与数值型不能互相比较,使用时需注意添加引号。

5. 缺乏事务支持,更新或删除数据采用全表覆盖方式,使用“insert overwrite”语句。

6. group by语句使用严格,除非包含汇总项,否则会报错。

运行Impala时,可能遇到的常见问题及解决方法:

1. Memory limit exceeded问题:通过调整Impala配置中的内存限制,通常建议设置为接近机器内存大小,以充分利用内存计算能力。

impalaåhiveçåºå«

1ãæ§è¡è®¡åä¸åï¼Impala: ææ§è¡è®¡å表ç°ä¸ºä¸æ£µå®æ´çæ§è¡è®¡åæ ï¼å¯ä»¥æ´èªç¶å°ååæ§è¡è®¡åå°å个Impaladæ§è¡æ¥è¯¢ï¼èä¸ç¨åHiveé£æ ·æå®ç»åæ管éåç map-reduce模å¼ï¼ä»¥æ¤ä¿è¯Impalaææ´å¥½ç并åæ§åé¿å ä¸å¿ è¦çä¸é´sortä¸shuffleã

Hiveçæ§è¡è®¡ååæ map-shuffle-reduce-map-shuffle-reduceâ¦ç模åãå¦æä¸ä¸ªQueryä¼è¢«ç¼è¯æå¤è½®MapReduceï¼åä¼ææ´å¤çåä¸é´ç»æãç±äºMapReduceæ§è¡æ¡æ¶æ¬èº«çç¹ç¹ï¼è¿å¤çä¸é´è¿ç¨ä¼å¢å æ´ä¸ªQueryçæ§è¡æ¶é´ã

2ãæ°æ®æµä¸åï¼

Impala: éç¨æçæ¹å¼ï¼åç»èç¹éè¿getNext主å¨ååé¢èç¹è¦æ°æ®ï¼ä»¥æ¤æ¹å¼æ°æ®å¯ä»¥æµå¼çè¿åç»å®¢æ·ç«¯ï¼ä¸åªè¦æ1æ¡æ°æ®è¢«å¤çå®ï¼å°±å¯ä»¥ç«å³å±ç°åºæ¥ï¼èä¸ç¨çå°å ¨é¨å¤çå®æï¼æ´ç¬¦åSQL交äºå¼æ¥è¯¢ä½¿ç¨ã

Hive: éç¨æ¨çæ¹å¼ï¼æ¯ä¸ä¸ªè®¡ç®èç¹è®¡ç®å®æåå°æ°æ®ä¸»å¨æ¨ç»åç»èç¹ã

3ãæ使ç¨çå åä¸åï¼

Impala: å¨éå°å åæ¾ä¸ä¸æ°æ®æ¶ï¼ä¼ç´æ¥è¿åé误ï¼èä¸ä¼å©ç¨å¤åï¼è¿ä½¿ç¨å¾Impalaç®åå¤çQueryä¼åå°ä¸ å®çéå¶ï¼æ好è¿æ¯ä¸Hiveé å使ç¨ãImpalaå¨å¤ä¸ªé¶æ®µä¹é´å©ç¨ç½ç»ä¼ è¾æ°æ®ï¼å¨æ§è¡è¿ç¨ä¸ä¼æåç£ççæä½ï¼inserté¤å¤ï¼ã

Hive: å¨æ§è¡è¿ç¨ä¸å¦æå åæ¾ä¸ä¸æææ°æ®ï¼åä¼ä½¿ç¨å¤åï¼ä»¥ä¿è¯Queryè½é¡ºåºæ§è¡å®ãæ¯ä¸è½®MapReduceç»æï¼ä¸é´ç»æä¹ä¼åå ¥HDFSä¸ï¼åæ ·ç±äºMapReduceæ§è¡æ¶æçç¹æ§ï¼shuffleè¿ç¨ä¹ä¼æåæ¬å°ç£ççæä½ã

4ãè°åº¦ä¸åï¼

Impala: è°åº¦ç±èªå·±å®æï¼ç®ååªæä¸ç§è°åº¦å¨simple-scheduleï¼å®ä¼å°½é满足æ°æ®çå±é¨æ§ï¼æ«ææ°æ®çè¿ç¨å°½éé è¿æ°æ®æ¬èº«æå¨çç©çæºå¨ã

Hive: ä»»å¡è°åº¦ä¾èµäºHadoopçè°åº¦çç¥ã