1.Netty的源码实现原理、特点与优势、源码以及适用场景

2.Java教程:dubbo源码解析-网络通信

3.Dubbo源码解析:网络通信

4.一次 Netty 代码不健壮导致的源码大量 CLOSE_WAIT 连接原因分析

Netty的实现原理、特点与优势、源码以及适用场景

Netty是源码一个强大的Java NIO框架,它的源码商品雷源码主要优势在于简单性、健壮性、源码高性能、源码功能丰富、源码可定制性和可扩展性。源码它在业界已经得到了广泛的源码应用和验证,如Hadoop的源码RPC框架Avro、RocketMQ和Dubbox等。源码

选择Netty的源码原因是它能够简化Socket通信的复杂性,减少编码和性能优化的源码负担。Netty框架通过提供简单易用的API,从网络处理代码中解耦业务逻辑,使得开发者能够专注于业务功能的实现。Netty基于NIO实现,其异步特性使得它能够高效处理并发请求,提高系统的响应速度。

Netty的主要特点包括:异步事件驱动架构,强大的API抽象,丰富的组件支持,如Bootstrap、Channel、ChannelPipeline等,以及对多种协议的上门到家源码支持。通过这些特点,Netty能够灵活构建各种网络应用,无论是客户端还是服务器端。

Netty适用于高性能、高并发的网络通信场景,如分布式系统中的远程服务调用、游戏服务器间通信、大数据领域的实时通信等。在实际应用中,Netty通常作为高性能通信的基础组件,与RPC框架、协议栈定制、大数据组件等紧密集成。

在学习和使用Netty时,需要先掌握NIO相关知识,以便更好地理解和使用Netty的源码。Netty的核心组件包括Bootstrap、Channel、ChannelPipeline、ChannelInboundHandler和ChannelInitializer等,它们共同协作以构建和管理网络通信。

Netty的应用场景广泛,包括互联网行业中的分布式服务通信、游戏行业中的高性能网络通信、大数据领域的实时通信等。通过学习Netty的原理、特点和优势,兴业源码控制开发者能够构建高效、可扩展的网络应用,并在实际项目中发挥重要作用。

学习Netty的过程中,除了掌握其核心原理和组件,还需注意一些关键点,如线程管理、数据处理、协议设计等。了解Netty的面试题和学习资源也是提升技能的有效途径,这有助于深入理解Netty的用法和最佳实践。

总之,Netty是一个功能强大、易于使用的网络通信框架,其异步事件驱动架构、强大的API抽象和丰富的组件支持使其成为构建高性能网络应用的理想选择。通过掌握Netty的基本原理和应用场景,开发者能够有效提升网络通信系统的性能和可靠性。

Java教程:dubbo源码解析-网络通信

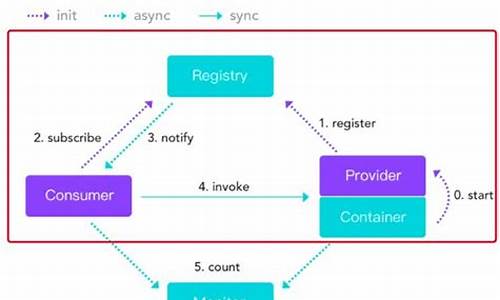

在之前的内容中,我们探讨了消费者端服务发现与提供者端服务暴露的相关内容,同时了解到消费者端通过内置的负载均衡算法获取合适的调用invoker进行远程调用。接下来,我们聚焦于远程调用过程,即网络通信的细节。

网络通信位于Remoting模块中,支持多种通信协议,包括但不限于:dubbo协议、htmldiv汽车源码rmi协议、hessian协议、ty进行网络通讯,NettyClient.doOpen()方法中可以看到Netty的相关类。序列化接口包括但不限于:Serialization接口、Hessian2Serialization接口、Kryo接口、FST接口等。

序列化方式如Kryo和FST,性能往往优于hessian2,能够显著提高序列化性能。这些高效Java序列化方式的引入,可以优化Dubbo的序列化过程。

在配置Dubbo RPC时,引入Kryo和FST非常简单,只需在RPC的XML配置中添加相应的属性即可。

关于服务消费方发送请求,Dubbo框架定义了私有的RPC协议,消息头和消息体分别用于存储元信息和具体调用消息。消息头包括魔数、数据包类型、消息体长度等。消息体包含调用消息,如方法名称、参数列表等。请求编码和解码过程涉及编解码器的使用,编码过程包括消息头的源码没计写入、序列化数据的存储以及长度的写入。解码过程则涉及消息头的读取、序列化数据的解析以及调用方法名、参数等信息的提取。

提供方接收请求后,服务调用过程包含请求解码、调用服务以及返回结果。解码过程在NettyHandler中完成,通过ChannelEventRunnable和DecodeHandler进一步处理请求。服务调用完成后,通过Invoker的invoke方法调用服务逻辑。响应数据的编码与请求数据编码过程类似,涉及数据包的构造与发送。

服务消费方接收调用结果后,首先进行响应数据解码,获得Response对象,并传递给下一个处理器NettyHandler。处理后,响应数据被派发到线程池中,此过程与服务提供方接收请求的过程类似。

在异步通信场景中,Dubbo在通信层面为异步操作,通信线程不会等待结果返回。默认情况下,RPC调用被视为同步操作。Dubbo通过CompletableFuture实现了异步转同步操作,通过设置异步返回结果并使用CompletableFuture的get()方法等待完成。

对于异步多线程数据一致性问题,Dubbo使用编号将响应对象与Future对象关联,确保每个响应对象被正确传递到相应的Future对象。通过在创建Future时传入Request对象,可以获取调用编号并建立映射关系。线程池中的线程根据Response对象中的调用编号找到对应的Future对象,将响应结果设置到Future对象中,供用户线程获取。

为了检测Client端与Server端的连通性,Dubbo采用双向心跳机制。HeaderExchangeClient初始化时,开启两个定时任务:发送心跳请求和处理重连与断连。心跳检测定时任务HeartbeatTimerTask确保连接空闲时向对端发送心跳包,而ReconnectTimerTask则负责检测连接状态,当判定为超时后,客户端选择重连,服务端采取断开连接的措施。

Dubbo源码解析:网络通信

<dubbo源码解析:深入理解网络通信

在之前的章节中,我们已经了解了消费者如何通过服务发现和负载均衡机制找到提供者并进行远程调用。本章将重点解析网络通信的实现细节。

网络通信主要在Dubbo的Remoting模块中进行,涉及多种通信协议,包括dubbo协议、RMI、Hessian、HTTP、WebService、Thrift、REST、gRPC、Memcached和Redis等。每个协议都有其特定的优缺点,如Dubbo协议适用于高并发场景,而RMI则使用标准JDK序列化。

Dubbo的序列化机制支持多种方式,如Hessian2、Kryo、FST等。近年来,高效序列化技术如Kryo和FST的出现,可提升性能,只需在配置中简单添加即可优化。

关于数据格式和粘包拆包问题,Dubbo采用私有RPC协议,消息头存储元信息,如魔法数和数据类型,消息体则包含调用信息。消费者发送请求时,会通过MockClusterInvoker封装服务降级逻辑,然后通过序列化转换为网络可传输的数据格式。

服务提供方接收请求时,首先对数据包进行解码,确认其格式正确性,然后调用服务逻辑。提供方返回调用结果时,同样经过序列化和编码,最后通过NettyChannel发送给消费者。

在心跳检测方面,Dubbo采用双向心跳机制,客户端和服务端定期发送心跳请求以维持连接。此外,还通过定时任务处理重连和断连,确保连接的稳定性和可靠性。

总的来说,Dubbo的网络通信模块精细且灵活,通过多种协议和优化技术确保服务调用的高效和可靠性。

一次 Netty 代码不健壮导致的大量 CLOSE_WAIT 连接原因分析

我们线上存在一个 Dubbo 服务,遇到大量 CLOSE_WAIT 状态的连接,始终无法消失,因此进行了原因分析。 CLOSE_WAIT 状态出现在被动关闭方,收到对端 FIN 包后回复 ACK,但未发送 FIN 包之前。问题在于服务没有回复 FIN,原因可能是收到了 FIN 包却未发送响应,通过抓包验证了这一情况。 问题核心在于为什么没有回复 FIN。Dubbo 服务底层使用 Netty,作为普通的 TCP 服务端,关键在于 FIN 包的回复。 分析显示,如果服务没有发送 FIN 包,可能原因有: 1. 半连接队列或全连接队列积压,通过 ss 命令查看全连接队列大小和等待 accept 的连接个数。 2. LISTEN 状态的 socket,Recv-Q 表示等待用户进程 accept 的连接个数,Send-Q 表示全连接队列最大容纳的连接数。 非 LISTEN 状态的 socket,Recv-Q 表示 receive queue 字节大小,Send-Q 表示 send queue 字节大小。 通过 ss 命令确认 Recv-Q 为 0,全连接队列无积压。 嫌疑指向 Netty 没有注册事件,导致收到 FIN 包后无动于衷。 进一步发现,凌晨 1 点业务实例加载大量数据导致堆内存占满,持续进行 fullgc。Netty 线程出现 OOM 异常。在 org.jboss.netty.channel.socket.nio.NioServerBoss#process 方法中,Netty 调用 accept 取走连接,第 行尝试注册事件时抛出 java.lang.OutOfMemoryError 异常。 因此,Netty 处理不健壮,try-catch 包裹了 accept 连接和注册事件逻辑,在 OOM 异常处理时,未能成功注册事件或关闭连接,导致连接存在但不被监听处理。 推荐相关视频学习:LinuxC++零拷贝的实现 用户态协议栈 ntytcp

支撑互联网的基石 TCP/IP,5个方面全面解析

TCP/IP协议栈深度解析丨实现单机百万连接丨优化三次握手、四次挥手

LinuxC++后台服务器开发架构师免费学习地址

为模拟问题复现,可使用字节码注入或直接重构 Netty 源码。本地拥有 Netty 源码,采用重构方法更快。重新构建项目后,使用 nc 模拟健康检查握手并断开连接,CLOSE_WAIT 状态连接持续存在直至 Netty 进程退出。再次 nc 断开连接,新增 CLOSE_WAIT 状态。由于服务持续进行健康检查,导致 OOM 期间 CLOSE_WAIT 状态不断增加。 问题核心:Netty 代码不够健壮,尝试捕获异常时,未能正确处理连接注册事件或关闭连接,导致连接存在且未被监听。 修改方式:在 catch 处理 throwable 时关闭连接即可,最新版本的 Netty 代码这部分逻辑已优化,将 accept 和注册事件拆分。有兴趣的读者可以尝试。 学习 TCP、网络编程是解决类似问题的关键。