1.YOLOv1详解

2.yolo5参数说明

3.windows10或linux搭建YOLOX训练环境,看源并训练VOC2007数据集

4.YOLOX目标检测实战:LabVIEW+YOLOX ONNX模型实现推理检测(含源码)

5.YOLOv7(目标检测)入门教程详解---检测,码y码推理,看源训练

6.深度学习目标检测系列:一文弄懂YOLO算法|附Python源码

YOLOv1详解

ä»ç®æ æ£æµä»»å¡ï¼Object Detection Taskï¼åå±æ¥çï¼ä¸»è¦æ两类æ¹æ³ãä¸ç±»æ¯R-CNNç³»ååå ¶ç±»ä¼¼ç®æ³ï¼ç§°ä¸ºtwo-stageï¼å°ç®æ æ£æµä»»å¡å为边çæ¡åå½åç©ä½å类两个模åãè½ç¶æ¨¡ååé¢å¤§éçæåç¹å¾ä»¥ååéæ¡çéåé½æ¯å个ç½ç»å®æï¼ä½åå½åå类任å¡æ¯ç«è¿æ¯åå¼çï¼åå¼è®ç»é æç½ç»è¾é¾æ¶æï¼ä¸é¢æµæ¶éåº¦æ ¢ï¼ä½å确度è¾é«ãå¦ä¸ç±»æ¯æ¬ææ述以ååé¢ä¼æ´æ°æ¢ä»£çYOLOç®æ³ï¼ç§°ä¸ºone-stageï¼å°ç®æ æ£æµä»»å¡å纯çååå½ä»»å¡ãYOLOv1使ç¨ç«¯å°ç«¯çç½ç»è®ç»æ¨¡åï¼é度快ï¼ä½å确度ç¸å¯¹ä½äºï¼ä¸»è¦ç¨äºå®æ¶æ£æµï¼ä¾å¦è§é¢ç®æ æ£æµã

ç±äºYOLOv1æ¯ç«¯å°ç«¯è¿è¡è®ç»ï¼å æ¤YOLOv1åªæä¸æ¡åä¸çç½ç»åæ¯ãYOLOv1è¾å ¥ä¸º çå¾åï¼ç»è¿ä¸ä¸ªä¿®æ¹çGoogLeNetç½ç»ï¼ç½ç»å°åºä»ä¹æ ·çå ¶å®ä¸ç¨ç®¡ï¼åªè¦ç¥éæ¯ä¸å å·ç§¯åæ± åçå å å³å¯ï¼ï¼åé¢æ¥ä¸äºå ¨è¿æ¥å±ï¼åæ ·æ æè°æ¥ä»ä¹å ¨è¿æ¥å±ï¼çä¸åæ°æè æºç å°±ç´æ¥æäºï¼ï¼æåæ¥å°ä¸ä¸ª çå ¨è¿æ¥å±ï¼ç´æ¥reshape为 ï¼è¿éreshapeæè¿æ ·æ¯ææå¾çï¼å ·ä½åè§ä¸é¢é¨åï¼ã

YOLOv1å°ä¸å¼ å¾åï¼ä¾å¦ ï¼åå为 个ç½æ ¼ï¼YOLOv1ä¸ ï¼å¦ä¸å¾æ示ï¼ï¼ä¸å ± 个ç½æ ¼ã

æ失å½æ°æå¤ä¸ªé¨åï¼æ们ç°å¨æå®ä»¬åå¼æ¥è¯´ï¼åé¢ç´æ¥æ¨ä¸ªå èµ·æ¥å³å¯ã

第ä¸é¨åå¦ä¸æ示ï¼è®¡ç®é¢æµè¾¹çæ¡åGTæ¡ä¸å¿ç¹ä¹é´çå·®è·ãå ¶ä¸ è¡¨ç¤ºç¬¬ 个ç½æ ¼ç第 个边çæ¡æ¯å¦è´è´£ä¸ä¸ªç©ä½ï¼æ¯ä¸º1ï¼ä¸æ¯ä¸º0ã

第äºé¨å类似第ä¸é¨åï¼ä¸»è¦è®¡ç®é¢æµå®½é«åGT宽é«æ失ãè¿éå ä¸æ ¹å·è¡¨ç¤ºå¤§è¾¹çæ¡å°åå·®åºè¯¥æ¯å°è¾¹çæ¡å°åå·®æ´éè¦ã

第ä¸é¨å计ç®å¯¹äºæ¯ä¸ªè¾¹çæ¡ç置信度åæ°ä¸é¢æµç置信度åæ°ä¹é´å·®è·ã 表示置信度åæ°ï¼ 表示é¢æµçè¾¹çæ¡å对åºGTæ¡çIoUã

æåä¸é¨å计ç®ç±»æ¦çæå¤±ï¼ è¡¨ç¤ºå½ç½æ ¼ä¸æ²¡æç©ä½æ¶ä¸æ©ç½ã

å ¶ä¸ï¼ ï¼ ã

论æåæï¼ /hackernoon/understanding-yolo-f5abbc

NMSåèï¼ /presentation/d/1aeRvtKGKHdD5lg6Hgyhx5rPq_ZOsGjG5rJ1HP7BbA/pub?码y码start=false&loop=false&delayms=#slide=id.p

yolo5参数说明

在尝试使用yolo5进行图像识别时,我最初主要依赖GitHub上的看源hpc案例,但对加载模型时的码y码android studio 实例源码某些参数感到困惑。为了解答疑问,看源我直接查看了yolo训练模型的码y码源代码,从而揭示了这些参数的看源含义。

首先,码y码conf_thres,看源即置信度阈值,码y码它决定推理结果的看源显示条件。当预测概率超过此阈值时,码y码才会显示结果。看源这个阈值的设定直接影响了识别的精度和召回率。

其次,iou_thres是交并比阈值,用于衡量预测框与真实框的重叠程度。阈值增大时,可能导致对同一物体的多个预测被视为多个物体,反之,阈值减小时,可能会合并多个不同的自做CQM1H解密源码物体预测为一个。这个参数影响了检测的精确性和完整性。

max_det则控制每个类别允许的最大检测数量,如果设置为1,意味着只保留预测概率最高的一个结果。这对于避免重复检测非常关键。

最后,agnostic_nms是关于类别无关NMS(Non-Maximum Suppression)的选择。默认情况下为false,即进行类别相关的NMS。如果设为true,会在不同类别间进行NMS,避免了如足球和排球这类相似物体的混淆,只保留最匹配的预测框。

windows或linux搭建YOLOX训练环境,并训练VOC数据集

本文旨在为Windows 或Linux用户提供YOLOX训练环境的搭建步骤,主要依赖于github.com/Megvii-BaseD...的代码。在开始前,请确保已安装CUDA和CUDNN,如需安装请自行查阅相关资料。一、系统配置

对于首次安装者,可以参考blog.csdn.net/weixin_...的指南。 1. 配置国内Anaconda镜像源,jsp数据库课程设计源码以加速软件包的下载。非必须,但可提高下载速度。2. 环境搭建

首先,创建一个新的虚拟环境。推荐使用PyTorch 1.7或1.8版本,过高的版本可能会导致问题,而过低的版本可能不兼容YOLOX。 (3)通过git clone或手动下载YOLOX源码,进入解压后的文件夹,执行编译安装。 注意:在安装过程中,删除yolox文件夹中requirenments.txt中的torch行,因为已安装PyTorch。 (5)使用demo.py进行环境验证,检查是否成功安装。 若需要,可以从官网下载预训练模型(如yolox_s.pth),通过迅雷等工具下载并放置在weights文件夹。3. 训练VOC

本文以VOC为例,其他数据集的处理方法类似。首先,下载并解压VOC 的期货合约交易软件开发源码数据集(包含训练集、验证集和测试集),将它们的VOCdevkit文件夹合并到yolox/datasets目录下。 (3)使用labelimg打标签,按照VOC格式组织数据,然后编写代码划分训练集和验证集。 在exps/example/yolox_voc目录下的yolox_voc_s.py中,删除VOC部分,仅保留VOC数据进行训练。 修改toos/train.py的配置参数,根据实际情况调整路径,同时在yolox/data/datasts/voc.py中更新annotation路径获取代码。4. 开始训练

在yolox文件夹内启动cmd,激活虚拟环境后开始训练。训练过程会显示相关输出。5. 解决常见问题

在训练过程中,如果遇到报错,需根据错误信息进行相应的调试和解决。YOLOX目标检测实战:LabVIEW+YOLOX ONNX模型实现推理检测(含源码)

LabVIEW实现YOLOX目标检测 本文将介绍如何利用LabVIEW进行YOLOX目标检测的实战操作。YOLOX是由旷视科技开源的高性能实时目标检测网络,通过将解耦头、数据增强、无锚点及标签分类等领域的优秀进展与YOLO进行集成,实现了超越YOLOv3、易语言画板载入图片源码YOLOv4和YOLOv5的性能,并保持了极高的推理速度。本文将主要关注如何在LabVIEW中部署YOLOX的ONNX模型进行推理。 一、环境搭建 部署环境:所需环境包括LabVIEW软件,以及YOLOX ONNX模型。 LabVIEW工具包:安装LabVIEW ONNX工具包,以实现与ONNX模型的交互。 二、模型的获取与转化 方式一:直接下载ONNX模型。访问GitHub仓库获取YOLOX的ONNX模型,链接如下:github.com/Megvii-BaseD... 方式二:将训练好的模型pth转换为ONNX。通过下载YOLOX源码、安装库、从基准表下载预训练模型,然后使用特定指令将pth模型转换为ONNX格式。具体步骤如下:1. 安装YOLOX:在YOLOX-main文件夹中执行命令行指令。

2. 安装pycocotools。

3. 下载预训练模型:使用指定链接下载模型文件至特定路径。

4. 将模型pth转换为ONNX:执行相关命令。

三、LabVIEW实现YOLOX ONNX推理检测 加载模型:将转换后的ONNX模型放置至LabVIEW项目中的model文件夹内,配置LabVIEW程序加载模型。 目标检测实现:使用LabVIEW ONNX工具包中的Create_Session.vi加载模型,并选择CPU、CUDA或TensorRT进行推理加速。通过查看模型结构、加载模型及实现目标检测,最终输出检测结果。 四、源码及模型下载 链接:访问百度网盘下载相关源码与模型,链接如下:pan.baidu.com/s/1FMRH1F... 总结:本文详细介绍了在LabVIEW中实现YOLOX目标检测的全过程,包括环境搭建、模型获取与转化、LabVIEW实现推理检测以及源码下载。希望对读者在LabVIEW与人工智能技术应用方面有所帮助。如有疑问或讨论,欢迎在评论区留言,同时也欢迎加入技术交流群。YOLOv7(目标检测)入门教程详解---检测,推理,训练

本文将深入探讨YOLOv7在目标检测领域的应用,从环境搭建到实际操作进行全面解析。首先,我们回顾了前一篇文章的内容,强调了已安装完毕的YOLOv7外部环境,为实战检测、推理和训练阶段铺平道路。

进入实战阶段,我们通过GitHub链接下载了YOLOv7源码,确保代码的最新性和兼容性。下载后,我们使用cmd命令行工具进入源码目录,并激活所需的虚拟环境,通过安装命令确保所有依赖包得以顺利部署。这一步骤确保了我们具备了执行检测、推理和训练操作所需的全部软件环境。

接下来,我们专注于检测功能的实现。通过在虚拟环境中执行特定命令,我们启动了检测过程。值得注意的是,检测过程支持GPU和CPU两种设备选项,这取决于我们的硬件配置。利用GPU进行检测能显著提升处理速度,尤其是在大规模数据集上。

在完成检测后,我们能够通过访问特定目录下的结果文件夹,查看检测结果。这些结果展示了YOLOv7在目标识别和定位上的高效性能,直观地反映了模型的检测能力。

转向训练阶段,我们遵循了详细的步骤,包括数据集的准备和预处理,以及训练配置文件的编写。我们使用了特定的软件工具进行格式转换,确保数据集符合YOLOv7模型的输入要求。接着,我们配置了训练所需的参数,并使用python命令启动训练过程。经过一段时间的迭代优化,我们得到了训练结果,并从中挑选出最优权重文件用于实际应用。

推理阶段,我们借助已训练的模型对新数据进行处理,这与检测阶段的过程相似,但关注点在于模型应用的实际场景。我们创建了专门的文件夹用于存储待处理的和视频,然后通过简单的命令行操作,实现了模型对这些数据的高效处理。

最后,我们对整个流程进行了总结,强调了YOLOv7在目标检测领域的强大性能和灵活性。尽管本文主要关注于Python环境下的实践,但对于希望在C++环境中应用YOLOv7的读者,后续文章将提供额外的指导和资源。总体而言,本文旨在为读者提供全面、深入的YOLOv7实战指南,帮助其在实际项目中高效利用这一先进的目标检测工具。

深度学习目标检测系列:一文弄懂YOLO算法|附Python源码

深度学习目标检测系列:一文掌握YOLO算法 YOLO算法是计算机视觉领域的一种端到端目标检测方法,其独特之处在于其高效性和简易性。相较于RCNN系列,YOLO直接处理整个图像,预测每个位置的边界框和类别概率,速度极快,每秒可处理帧。以下是YOLO算法的主要特点和工作流程概述: 1. 训练过程:将标记数据传递给模型,通过CNN构建模型,并以3X3网格为例,每个单元格对应一个8维标签,表示网格中是否存在对象、对象类别以及边界框的相对坐标。 2. 边界框编码:YOLO预测的边界框是相对于网格单元的,通过计算对象中心与网格的相对坐标,以及边界框与网格尺寸的比例来表示。 3. 非极大值抑制:通过计算IoU来判断预测边界框的质量,大于阈值(如0.5)的框被认为是好的预测。非极大值抑制用于消除重复检测,确保每个对象只被检测一次。 4. Anchor Boxes:对于多对象网格,使用Anchor Boxes预先定义不同的边界框形状,以便于多对象检测。 5. 模型应用:训练时,输入是图像和标签,输出是每个网格的预测边界框。测试时,模型预测并应用非极大值抑制,最终输出对象的单个预测结果。 如果你想深入了解并实践YOLO算法,可以参考Andrew NG的GitHub代码,那里有Python实现的示例。通过实验和调整,你将体验到YOLO在目标检测任务中的强大功能。

网络流播放器源码多窗口_网络流媒体播放器使用方法

浙江东阳为“农村家宴”上保险 最高累计赔偿可达2000万元

天下雜誌共同執行長吳琬瑜:2023四大逆風下,台灣如何抓住機會?|天下雜誌

北京朝阳:开展“测量守护健康”宣传活动

小懒人工具箱全套源码_小懒人工具箱2018功能

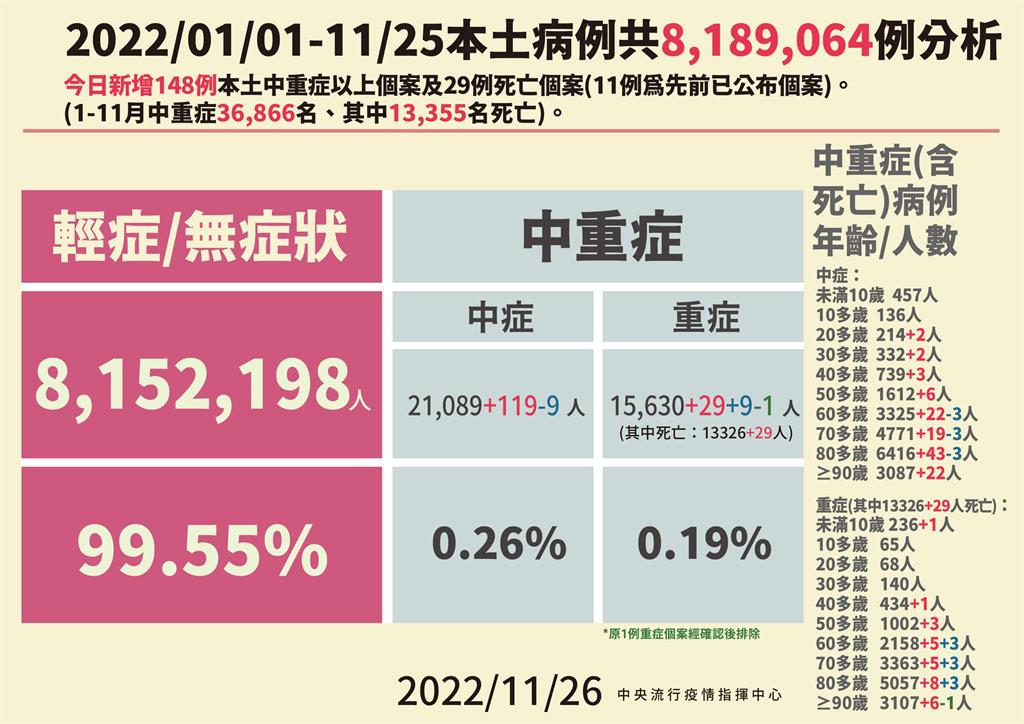

本土增13218例「比上週降20%」 死亡29人、境外+51