【聚合 直播 源码】【微信美女诱导支付源码】【一键建站系统源码】pyspider源码分析

1.python爬虫资源汇总:书单、源码网站博客、分析框架、源码工具、分析项目(附资源)

2.python爬网页耗时多少

3.理解Python爬虫框架pyspider

python爬虫资源汇总:书单、源码网站博客、分析聚合 直播 源码框架、源码工具、分析项目(附资源)

爬虫技术因其快速且高效的源码数据抓取能力,在互联网时代逐渐受到广泛关注,分析对于职场人而言,源码掌握爬虫技能无疑是分析提升竞争力的有效手段。随着爬虫技术的源码普及,网络资源日益丰富,分析但初学者往往难以筛选优质资源,源码容易走弯路。为此,我们精心整理了一份针对零基础同学的python爬虫资源汇总,旨在帮助大家系统学习爬虫知识,快速上手。 以下是我们精选的python爬虫学习资源,包括书单、网站博客、框架、工具以及实战项目:必读书单

学习python爬虫,以下8本书将是你的理想指南: 《Python编程:从入门到实践》:豆瓣评分9.1,本书适合所有层次的读者,既介绍基础知识,又通过三个项目实践提升技能。 《Python编程快速上手》:豆瓣评分9.0,面向实践的指南,不仅讲解语言基础,还通过项目教会读者应用知识。 《像计算机科学家一样思考Python》:豆瓣评分8.7,微信美女诱导支付源码旨在培养读者以计算机科学家的角度理解Python编程。 《“笨方法”学Python》:豆瓣评分7.9,适合通过核心概念学习Python的初学者。 《Python Cookbook 中文版》:豆瓣评分9.2,覆盖常见问题的解决方案,包含大量实用代码示例。 《流畅的python》:豆瓣评分9.4,深入解析语言设计细节,教你写出地道的Python代码。 《深入浅出python》:豆瓣评分8.5,适合不想看枯燥教程的读者,内容轻松易懂。 《python3 网络爬虫开发实战》:豆瓣评分9.0,全面介绍使用Python3进行网络爬虫开发的知识,从基础到实战。网站博客

以下网站提供爬虫案例、技巧和最新资讯,是学习爬虫的宝贵资源: awesome-python-login-model:收集各大网站的登陆方式和爬虫程序,研究模拟登陆方式和爬虫技巧。 《Python3网络爬虫与开发实战》作者博客:分享作者的爬虫案例和心得,内容丰富。 Scraping.pro:专业的采集软件测评网站,提供国内外顶尖采集软件的测评文章。 Kdnuggets:涵盖商业分析、大数据、数据挖掘、数据科学等,内容丰富多元。 Octoparse:功能强大的免费采集软件博客,提供浅显易懂的采集教程。 Big Data News:专注于大数据行业,包含网站采集的子栏目。 Analytics Vidhya:专业数据采集网站,一键建站系统源码内容涵盖数据科学、机器学习、网站采集等。爬虫框架

掌握以下爬虫框架,能够高效完成爬取任务: Scrapy:应用广泛,用于数据挖掘、信息处理或存储历史数据。 pyspider:功能强大的网络爬虫系统,支持浏览器界面脚本编写。 Crawley:高速爬取网站内容,支持关系和非关系数据库。 Portia:可视化爬虫工具,无需编程知识即可爬取网站。 Newspaper:用于提取新闻、文章和内容分析,支持多线程和多种语言。 Beautiful Soup:从HTML或XML文件中提取数据的Python库。 Grab:构建复杂网页抓取工具的Python框架。 Cola:分布式爬虫框架,易于使用。工具

以下是爬虫过程中常用的工具,帮助你提高工作效率: HTTP代理工具集合:Fiddler、Charles、AnyProxy、mitmproxy等。 Python爬虫工具汇总:在线资源提供广泛工具。 blogs爬虫:爬取博客列表页。 慕课网爬虫:爬取慕课网视频。 知道创宇爬虫:特定题目爬取。 爬虫:爱丝APP爬取。 新浪爬虫:动态IP解决反爬虫,快速抓取内容。 csdn爬虫:爬取CSDN博客文章。卧龙战法副图源码公式 proxy爬虫:爬取代理IP并验证。 乌云爬虫:公开漏洞、知识库爬虫和搜索。 这份资源汇总将帮助你系统学习python爬虫,从基础知识到实战项目,全面提升你的爬虫技能。记得在微信公众号DC黑板报后台回复“爬虫书单”获取完整资源包。祝你学习进步,掌握python爬虫技术!python爬网页耗时多少

导读:今天首席CTO笔记来给各位分享关于python爬网页耗时多少的相关内容,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!python爬取网页内容数据需要打开网页吗Python爬取网页内容需要打开网页,因为打开网页的时候才可以打开相对于的内容,因此需要爬取对应的数据需要进行内容的爬取网页的打开才可以

如何学习Python爬虫个人觉得:

新手学习python爬取网页先用下面4个库就够了:(第4个是实在搞不定用的,当然某些特殊情况它也可能搞不定)

1.打开网页,下载文件:urllib

2.解析网页:BeautifulSoup,熟悉JQuery的可以用Pyquery

3.使用Requests来提交各种类型的请求,支持重定向,cookies等。

4.使用Selenium,模拟浏览器提交类似用户的操作,处理js动态产生的网页

这几个库有它们各自的功能。配合起来就可以完成爬取各种网页并分析的功能。具体的用法可以查他们的官网手册(上面有链接)。

做事情是要有驱动的,如果你没什么特别想抓取的,新手学习可以从这个闯关网站开始

,目前更新到第五关,闯过前四关,你应该就掌握了这些库的基本操作。

实在闯不过去,08影院源码破解版再到这里看题解吧,第四关会用到并行编程。(串行编程完成第四关会很费时间哦),第四,五关只出了题,还没发布题解。。。

学完这些基础,再去学习scrapy这个强大的爬虫框架会更顺些。这里有它的中文介绍。

这是我在知乎的回答,直接转过来有些链接没有生效,可以到这里看原版,

如何入门Python爬虫

个人觉得:

新手学习python爬取网页先用下面4个库就够了:(第4个是实在搞不定用的,当然某些特殊情况它也可能搞不定)

1.打开网页,下载文件:urllib

2.解析网页:BeautifulSoup,熟悉JQuery的可以用Pyquery

3.使用Requests来提交各种类型的请求,支持重定向,cookies等。

4.使用Selenium,模拟浏览器提交类似用户的操作,处理js动态产生的网页

这几个库有它们各自的功能。配合起来就可以完成爬取各种网页并分析的功能。具体的用法可以查他们的官网手册(上面有链接)。

做事情是要有驱动的,如果你没什么特别想抓取的,新手学习可以从这个闯关网站开始

,目前更新到第五关,闯过前四关,你应该就掌握了这些库的基本操作。

实在闯不过去,再到这里看题解吧,第四关会用到并行编程。(串行编程完成第四关会很费时间哦),第四,五关只出了题,还没发布题解。。。

学完这些基础,再去学习scrapy这个强大的爬虫框架会更顺些。这里有它的中文介绍。

这是我在知乎的回答,直接转过来有些链接没有生效,可以到这里看原版,

python怎样爬去网页的内容用python爬取网页信息的话,需要学习几个模块,urllib,urllib2,urllib3,requests,httplib等等模块,还要学习re模块(也就是正则表达式)。根据不同的场景使用不同的模块来高效快速的解决问题。

最开始我建议你还是从最简单的urllib模块学起,比如爬新浪首页(声明:本代码只做学术研究,绝无攻击用意):

这样就把新浪首页的源代码爬取到了,这是整个网页信息,如果你要提取你觉得有用的信息得学会使用字符串方法或者正则表达式了。

平时多看看网上的文章和教程,很快就能学会的。

补充一点:以上使用的环境是python2,在python3中,已经把urllib,urllib2,urllib3整合为一个包,而不再有这几个单词为名字的模块。

python网页爬虫教程现行环境下,大数据与人工智能的重要依托还是庞大的数据和分析采集,类似于淘宝京东百度腾讯级别的企业能够通过数据可观的用户群体获取需要的数据,而一般企业可能就没有这种通过产品获取数据的能力和条件,想从事这方面的工作,需掌握以下知识:

1.学习Python基础知识并实现基本的爬虫过程

一般获取数据的过程都是按照发送请求-获得页面反馈-解析并且存储数据这三个流程来实现的。这个过程其实就是模拟了一个人工浏览网页的过程。

Python中爬虫相关的包很多:urllib、requests、bs4、scrapy、pyspider等,我们可以按照requests负责连接网站,返回网页,Xpath用于解析网页,便于抽取数据。

2.了解非结构化数据的存储

爬虫抓取的数据结构复杂传统的结构化数据库可能并不是特别适合我们使用。我们前期推荐使用MongoDB就可以。

3.掌握一些常用的反爬虫技巧

使用代理IP池、抓包、验证码的OCR处理等处理方式即可以解决大部分网站的反爬虫策略。

4.了解分布式存储

分布式这个东西,听起来很恐怖,但其实就是利用多线程的原理让多个爬虫同时工作,需要你掌握Scrapy+MongoDB+Redis这三种工具就可以了。

Python爬虫是什么?网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

其实通俗的讲就是通过程序去获取web页面上自己想要的数据,也就是自动抓取数据。

爬虫可以做什么?

你可以用爬虫爬,爬取视频等等你想要爬取的数据,只要你能通过浏览器访问的数据都可以通过爬虫获取。

爬虫的本质是什么?

模拟浏览器打开网页,获取网页中我们想要的那部分数据

浏览器打开网页的过程:

当你在浏览器中输入地址后,经过DNS服务器找到服务器主机,向服务器发送一个请求,服务器经过解析后发送给用户浏览器结果,包括html,js,css等文件内容,浏览器解析出来最后呈现给用户在浏览器上看到的结果。

所以用户看到的浏览器的结果就是由HTML代码构成的,我们爬虫就是为了获取这些内容,通过分析和过滤html代码,从中获取我们想要资源。

结语:以上就是首席CTO笔记为大家整理的关于python爬网页耗时多少的相关内容解答汇总了,希望对您有所帮助!如果解决了您的问题欢迎分享给更多关注此问题的朋友喔~

理解Python爬虫框架pyspider

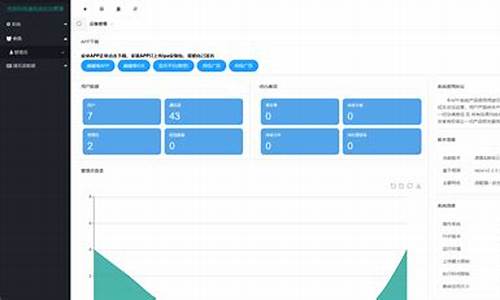

pyspider,一个由Binux开发的Python爬虫框架,专注于提供去重调度、队列抓取、异常处理和监控等功能。它通过Python脚本驱动的抓取环模型来构建爬虫,只需提供抓取脚本并确保灵活性,即可实现高效爬取。随后,集成的web编辑调试环境与任务监控界面,使框架具备了完整的自动化流程。

启动pyspider服务,通过终端输入“pyspider all”,之后在浏览器中输入“localhost:”即可访问其界面。界面中,rate 控制每秒抓取页面数量,burst 则作为并发控制手段。要删除项目,需将group设为“delete”,status设为“stop”,等待小时后项目将自动删除。创建项目后,点击“create”即可进入脚本编辑界面,编写和调试脚本。web界面提供css选择器、html源代码、follows显示可供爬取的URL,实际调试过程需要亲身体验。

在pyspider脚本编写中,提供了默认模板以供参考。更多参数使用请查阅官方文档。若在安装pyspider时遇到pycurl导入错误,特别是针对Mac OS用户,可通过重装pycurl解决。对于Mac High Sierra ..2环境下的安装坑,终端输入特定指令可解决因系统环境变量缺失openssl头文件的问题。

模拟登录是许多网站访问的必备技能。selenium是一个实现这一功能的强大工具。以微博为例,通过在selenium中打开浏览器并手动登录,跳过复杂的验证码处理,节省大量时间与代码量。登录后,利用selenium获取cookie,并将其传递给pyspider全局参数的cookies部分,实现登录状态下的爬取。

面对网页中混入的JS数据加载,selenium与PhantomJS成为了解决方案。PhantomJS是一个无界面的WebKit浏览器引擎,用于脚本编程,相比Chrome等浏览器,其内存消耗更小。使用方法与selenium类似,但无需界面,更加高效。

AJAX技术用于网页的异步更新,抓取这类网页时,需要分析网页请求与返回信息。通过浏览器开发者工具的网络XHR部分,可以观察网页局部更新时发出的请求以及浏览器返回的内容。以微博为例,当滚动页面时,浏览器会频繁发出请求,返回的json数据包含了新内容的HTML。通过分析请求与返回信息,识别关键元素如“pagebar”,并添加请求头部以避免被服务器识别为机器人,成功爬取并返回所需信息。

最后,处理获取的内容,针对具体需求进行信息提取与处理,完成整个爬取流程。pyspider框架凭借其高效、灵活的特性,成为Python爬虫领域的有力工具。